- +1

AI社会学|傲慢与偏见:奥巴马怎么“变白”了?

许多年之后,当我们追溯AI社会学的编年史,2020年深度学习大牛、Facebook 首席 AI 科学家杨乐昆(Yann LeCun)和 Google AI科学家蒂妮特·葛卜路(Timnit Gebru)在推特上进行的“算法偏见大辩论”也许仍然是值得记录的一笔。尽管这场沸反盈天的争论在持续两周之后,以杨乐昆宣布永远退出推特暂时画上了休止符,计算机学家和社会学家在算法里的分歧却远远没有得到解决。

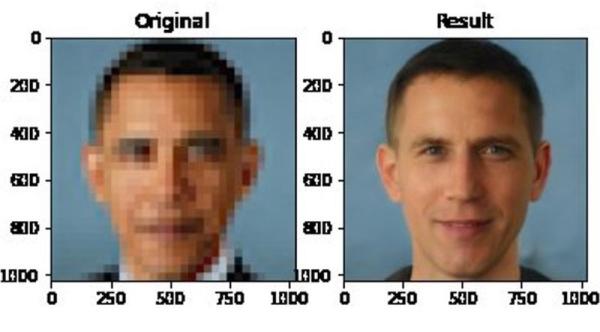

这场争论的起点是一个名为PULSE的算法,由杜克大学的科学家们在计算机视觉顶级会议CVPR 2020上发表。PULSE的精髓在于其利用生成对抗网络(GAN)的思路,将模糊的照片瞬间清晰化的能力。但很快,网友就发现,PULSE在黑人群体的表现差强人意。比如,将前总统奥巴马的模糊照片经过PULSE处理,生成的清晰图片竟然是一张白人面孔。

图片来源:Twitter网友chicken3gg

在全美BLM运动(Black Lives Matter,黑人的命也是命)如火如荼的当下,PULSE算法引发了巨大的争议。面对铺天盖地的质疑,杨乐昆发了一条推特,解释到:“机器学习系统的偏见是由数据造成的。PULSE系统使用FlickFaceHQ训练,其大部分是白人图片。如果系统使用塞内加尔的数据集训练,那所有人会看起来都像非洲人。”

从技术角度来说,杨乐昆指出了算法偏见一个至关重要的来源,就是训练数据集的偏见。但是,意识到数据偏见是否就足够了呢?Google AI 科学家、同时也是一名非裔女性的蒂妮特·葛卜路在推特上与杨乐昆展开了激烈的辩论。一时间风声鹤唳,计算机学家和社会学家纷纷站队。蒂妮特直言到:你不能将机器学习系统造成的伤害完全归结于数据偏见。换而言之,是否只要修正了数据偏见,算法偏见(及其造成的伤害)就自动消失了呢?

社会学家们的答案是否定的。对他们来说,一个至关重要的区分是中性的统计上的“偏差” (bias)和对社会群体造成实实在在后果的“偏见” (bias of moral import)。1996年,巴蒂娅·弗里德曼(Batya Friedman)和海伦·尼森鲍姆(Helen Nissenbaum)在互联网时代的早期写下了至今仍然是经典的《计算机系统的偏差》(Bias in Computer Systems)。当然,他们当年所说的偏见和今天AI系统里人们观察到的偏见已经截然不同。但是,他们提出了一个经典定义,区分开了bias和bias of moral import ——如果前者可以泛指计算系统里的各种自然的“偏差”,那么后者则指的是特定的会对某一社会群体造成的不公正的伤害。今天我们讨论算法偏见,更多是后者。

也许一个经典的例子是亚马逊和奈飞 (Netflix) 的算法推荐系统,你或许在淘宝和抖音上也能找到类似的系统。这些算法会根据你之前的浏览和评价记录(或与你用户画像类似用户的浏览及评价记录)向你推荐“或许”感兴趣的商品和影片。

统计学家们发现,类似的算法起码受制于四大统计偏差的束缚。第一类偏差,是新的商品或影片往往很难被推荐算法选中。因为算法基于用户评分,新的产品没有评分所以很难进入算法视野。

第二类偏差,是流行的商品或影片往往会被反复选中。即使你只阅读中古时期的医学史,也很有可能被推送《哈利波特》——因为在茫茫用户人海中,总有喜欢《哈利波特》的人碰巧也喜欢中古医学史。

第三类偏差更为复杂一点,统计学家们发现,算法有“过于精细”的特点。如果你碰巧看了三部《倚天屠龙记》,出于对精确性(accuracy)的不懈追求,算法基本就会持之以恒地给你继续推荐武侠小说,即使你这个礼拜想探索一下科幻电影。

第四类偏差,是同质化。因为算法会自动推荐其他用户喜欢的产品,评价少的小众产品会慢慢下沉,整个信息生态系统会变得越来越类似。比如,引用率高的论文会被反复引用,影响力增大的同时又会导致更多的引用,形成一个信息闭环。

社会学家们很快发现,当我们讨论统计偏差的时候,常常忽略了貌似正常的偏差在社会群体里造成的伤害。许多看上去完全自然无害的统计偏差可能导致严重的社会后果。在以上的例子里,过于精细的算法可能会导致个人信息系统的同质化,从而导致社会大环境的割裂:保守派和自由派也许看到的是完全不一样的世界。

类似的,如果算法的设计是为了“大部分用户”服务的,那些占据正态分布尾部的少数派用户群体自然会受到不同程度的“算法歧视”。从另一个角度来说,把正态分布尾部的用户群体排斥在算法的视野之外同样也是对“大多数”用户的伤害:人类信息系统和自然生态系统一样,会受损于多样性的丧失。

更致命的是,在类似的推荐系统,或者更广义上的现代信息过滤(information filtering)系统里,数据和算法是无法分割开的。算法不停地根据数以万计用户的选择和评分对自己的预测系统进行实时更新——哪里是数据偏见?哪里又是算法偏见?

更进一步,我们还可以问,把AI系统造成的社会偏见和伤害归结于“数据”而非“系统”本身,从某种程度上来说,是否也是在规避责任?如果只有数据是有偏见的,那么是否只有收集和标注数据的人才应该对这一切社会后果负责?把追责的视野局限在训练数据集上,我们其实是放弃了从起始处起对一整个AI系统进行问询的基础:为什么要建造这个系统?谁建造了这个系统?谁会受益于这个系统?谁又会受到最大程度的影响?

当代深度学习领军人物杨乐昆在激辩算法偏见两周之后,彻底退出了推特。在人类社会和算法的交界处,在AI算法争分夺秒从亿万用户的行为里提取数据进行预测的今天,仅仅从科技的角度来理解和解决问题或许会受到越来越多的挑战。

普林斯顿社会学家鲁哈·本杰明(Ruha Benjamin)在著名的深度学习大会 ICLR 2020上说:

“Computational depth without historical or sociological depth is superficial learning”。

没有历史和社会深度的“深度学习”只是“浅薄学习”。

与所有计算机学家和社会学家们共勉。

【参考文献】

[1] Batya Friedman and Helen Nissenbaum. "Bias in computer systems." ACM Transactions on Information Systems (TOIS) 14, no. 3 (1996): 330-347.

[2] Ruha Benjamin. “Vision: Reimagining the Default Settings of Technology & Society,” ICLR 2020.

[3] Sachit Menon, Alexandru Damian, Shijia Hu, Nikhil Ravi, Cynthia Rudin. “PULSE: Self-Supervised Photo Upsampling via Latent Space Exploration of Generative Models,” Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2020, pp. 2437-2445.

[4] Catherine Stinson. "Can an Algorithm be Biased?”. 2020.

-----

作者沈虹,毕业于美国伊利诺伊大学香槟分校传播学系,现任职于美国卡内基梅隆大学。她用社会学的方法研究新兴科技。

- 报料热线: 021-962866

- 报料邮箱: news@thepaper.cn

互联网新闻信息服务许可证:31120170006

增值电信业务经营许可证:沪B2-2017116

© 2014-2024 上海东方报业有限公司