- +1

图灵奖得主辛顿谈无监督学习问题根源:忽略数据间关联捕捉

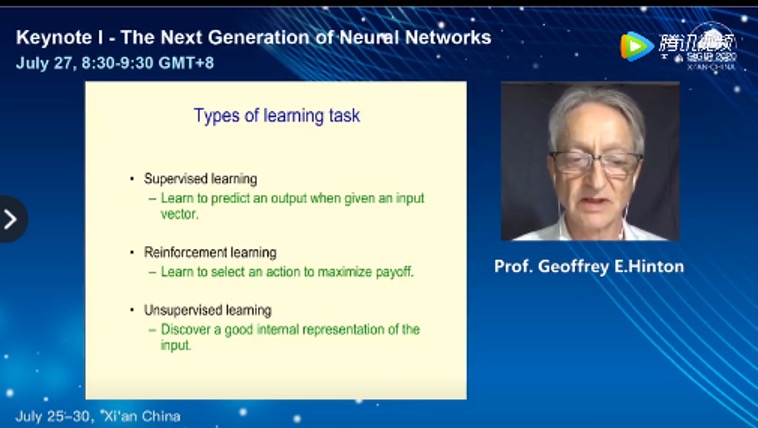

7月27日上午,近来鲜少露面的图灵奖获得者、多伦多大学计算机科学系名誉教授杰弗里·辛顿(Geoffrey Hinton)在第43届国际信息检索大会(SIGIR 2020)上作为首位主题演讲者,进行了题为“神经网络的新时代(The Next Generation of Neural Networks)”的主题报告。

他在报告中回顾了无监督神经网络的发展历史,结合表达学习模型的进化历程,指出当前无监督学习方法所面临问题的根源在于:过度关注数据的重构损失(Reconstructive Loss),忽略了对数据间关联关系的捕捉。

基于此,他提出了下一代神经网络模型的构想,提出利用对比损失函数(Contrastive Loss)建模样本间的局部关系、增强数据间表达的一致性的解决思路。

杰弗里·辛顿演讲视频截图

杰弗里·辛顿被称为“神经网络之父”,出生于1947年12月6日,是加拿大认知心理学家和计算机科学家。辛顿1970年毕业于剑桥国王学院,随后在英国爱丁堡大学获得人工智能博士学位。2019年3月,因对人工智能的繁荣发展奠基,杰弗里·辛顿、约书亚·本吉奥(Yoshua Bengio)和杨立昆(Yann LeCun)三人被授予2018年的图灵奖。

值得一提的是,杰弗里·辛顿近来很少在公开演讲中出现。2020年6月18日,他在个人推特上表示,因为发现之前对感知学习想法的“致命错误”,推掉了一段时间内接受的所有报告。

杰弗里·辛顿在7月27日的报告中回顾了三种不同类似的学习模式,即监督学习(学习在给定输入向量时预测输出)、强化学习(学习找出一个能够使收益最大化的选择)和无监督学习(在不提供监督信息的条件下进行学习)。

辛顿在报告中解释为什么需要无监督学习。他指出,人类大脑有10^14个神经元连接,而生命的长度只有10^9秒,因此人类是无法完全依赖有监督学习的方法完成所有神经元训练,而需要更多来自于无监督学习的帮助,受此启发,构建智能的机器模型也应综合考虑监督与无监督方法进行协同训练。

报告最后,他还展示了上述构想的一种具体实现方案SimCLR,应用该方案能够显著提升下游图像分类任务的效果。

- 报料热线: 021-962866

- 报料邮箱: news@thepaper.cn

互联网新闻信息服务许可证:31120170006

增值电信业务经营许可证:沪B2-2017116

© 2014-2025 上海东方报业有限公司