- +1

AI社会学︱算法的21种“公平”,你要哪一种?

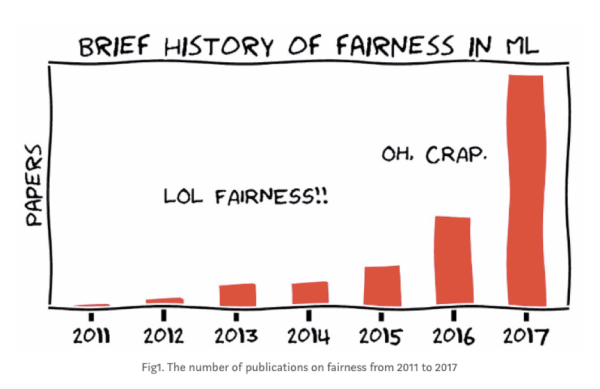

2016年5月,美国著名的非盈利媒体ProPublica发表了一篇题为《机器偏见》(Machine Bias) 的调查性报道。如果之前在人工智能和机器学习领域有关公平 (fairness) 和偏见 (bias) 的议题还只是小范围的学界争论,仅在FATML (Fairness, Accountability, and Transparency in Machine Learning) 等新兴会议里被讨论,这篇报道之后关键词里涉及“公平”的机器学习论文开始呈指数级增长。有普林斯顿计算机系教授阿尔文德•纳拉亚南(Arvind Narayanan)精心制作的美图为证:

在这篇影响力巨大的报道里,ProPublica分析了一个名为COMPAS的机器学习系统。在美国地方的司法体系里,COMPAS被广泛应用于预测被告的再犯几率,作为建议量刑的基础。基于一系列复杂的历史数据,包括年龄、性别和已有的犯罪记录,COMPAS预测案件行为人(或被告)被再次逮捕的概率,得出一个1到10分之间的 “危险分” (risk score) 供法官参考:分数越高,行为人被再次逮捕的概率越高,也就越危险。

机器学习的拥趸们认为,比起人类法官们固有的歧视和偏见,利用大数据得出的结论要客观中立的多。毕竟,数据不会说谎,算法永远客观,不是吗?然而,ProPublica的报道提示了另外一种可能。报告利用公开数据,分析了佛罗里达州布劳沃德县(Broward County)1.8万人的COMPAS分数和犯罪记录,得出了一个惊人的发现:尽管COMPAS的正确预测率达到了61%,在它的系统里,黑人与白人的分数分布却明显不同。黑人更有可能被误判,即被预测为高风险却没有再犯,白人则更有可能被漏判,即被预测为低风险却再次犯罪。不同种族间的误判 (false positive) 和漏判 (false negative) 率的差距可以高达50%。

有趣的是,故事在这里并没有结束。在ProPublica报道发布并引起巨大争议之后,COMPAS的母公司做出了正面回应。它重新在ProPublica的数据上运行了自己的算法,并公布了自己算法在不同种族之间的分布。COMPAS争论道,他们的系统是“公平”的,而公平依据是,在他们的算法里,无论黑人白人,预测为高风险的被告再次犯罪的概率都是相同的。也就是说,如果你采取的公平定义不是误判和漏报率,而是高风险的预测正确率 (predictive parity) 的话,COMPAS的算法并无偏见和歧视之说。

接下来,机器学习和统计学领域的大牛们就这个问题展开了精彩的辩论,各种关于公平的数学定义层出不穷,一度达到21种之多。统计学家们很快发现,COMPAS与ProPublica衡量公平的标准存在冲突。他们采用的公平定义都是抵达某一种“公平”的方式,但如果两个群体之间本身用来训练模型的数据存在差异(在COMPAS的例子里,黑人的总体再犯率比白人要高),那么在统计上各种“公平”的定义就是不可兼容的。也就是说,算法不可能兼顾ProPublica提出的“公平” 和COMPAS提出的“公平”。即使数学上可能会有完美的“公平”定义,在现实世界的复杂社会关系里,完美且唯一正确的“公平”是不存在的。

纳拉亚南在他2018年FATML的教程里戏谑道:现在“公平”这么热门,如果你想在机器学习的各大会议上灌水,可以想想怎样再多开发一些复杂的、统计学意义上的“公平”定义。这当然是玩笑话。他想进一步指出的是,光致力于发展统计学上严格的“公平”定义可能是徒劳的,不论在数学上有多么严谨。因为不仅人类世界不可能有完美的“公平”算法,每一种所谓的“公平”法则背后其实都是复杂的社会关系和政治诉求。

在COMPAS的例子里,案件行为人或被告最关心的可能是误判 (false positive) ,而城市居民们最关心的可能是漏判 (false negative),两者是此消彼长的关系,不可能全部满足。那么,谁的利益应该放在前面?如果必须作出取舍的话,算法里这条取舍的线应该画在哪里?

1980年,社会学家兰登•温纳(Langdon Winner)写下了至今仍然是经典名篇的《技术有政治吗》(Do artifacts have politics)。其议题在算法统治世界的今天仍然重要,也许比任何时候都更加重要。

当时温纳在科技重镇麻省理工力排众议,探讨科技产物和社会关系的复杂互动。他认为,科技产物是有政治性的,而过去政治哲学的讨论里大大低估了科技的重要性。但这里的“政治性”并非单向度的“科技影响社会”或是“社会影响科技”;科技在与社会的复杂互动里生成,进化,并深刻地嵌入和塑造当时当地的历史社会和权力关系之中。

温纳举了1940年代由加州大学研究员在当地开发并推广的番茄收割机作为其中的一个例子。相比手动收割,机器收割可以大大提高效率。可是,虽然以效率和现代之名推广,这一新兴技术却并没有使当地居民平等地享有它的经济收益。缺少有效的社会反思和合适的政策约束,昂贵的机器虽然提高了生产力和生产效率,却促进了番茄种植业的工业化和集中化,大大减少了当地小农种植者和手工收割者的工作岗位,致使无数劳动者流离失所。看上去微不足道的小小机器最终以一种令人惊讶的方式彻底重构了当地的社会和经济关系。

温纳总结到,“the thing we called ‘technologies’ are ways of building order in our world.” 我们所说的“科技”其实是在这个世界上(重新)建立秩序和规则的方式,算法同理:谁受益?谁受损?谁得到更大的权力?谁受到更多的伤害?谁被包含进来?谁又被排除在外?

每年讲完COMPAS的案例,都会有学生质疑:你讲了那么多,具体来说我们到底该怎么做(what are the actionable items here)?21种不同的公平定义,我们调试模型的时候应该使用哪一种?彼时我在计算机学院浸淫稍久,深知 “actionable items”乃是社会学家和计算机学家的根本分歧,红海两分,从此无法对话。社会学家的根本目的常常并不是解决问题,并对一切声称能将复杂人类问题简单化和算法化的路径持有质疑,而工程师的程序里少了一个括号都无法运行。每当这个时候,我都会面露诡异微笑,祭出计算机大牛辛西娅•德沃克(Cynthia Dwork)在这场“公平大辩论”里的名言:

“Fairness” metric is assumed to be public and open to discussion and continual refinement.

当“公平”本身是社会的和政治的,算法不可能也不会是社会关系的绝缘体。我们能做的第一个“actionable item,”就是把黑箱打开,然后开始问,我们想要的,到底是什么样的算法“公平”?

【参考文献】

[1] Angwin, Julia, Jeff Larson, Surya Mattu, and Lauren Kirchner. "Machine bias." ProPublica, May 23 (2016): 2016.

[2] Narayanan, Arvind. "21 definitions of fairness and their politics. (Feb.23, 2018)." In Tutorial presented at the Conference on Fairness, Accountability, and Transparency, vol. 21.

[3] Dieterich, William, Christina Mendoza, and Tim Brennan. "COMPAS risk scales: Demonstrating accuracy equity and predictive parity." Northpointe Inc (2016).

[4] Feller, Avi, Emma Pierson, Sam Corbett-Davies, and Sharad Goel. "A computer program used for bail and sentencing decisions was labeled biased against blacks. It’s actually not that clear." The Washington Post (2016).

[5] Winner, Langdon. "Do artifacts have politics?" Daedalus (1980): 121-136.

[6] Dwork, Cynthia, Moritz Hardt, Toniann Pitassi, Omer Reingold, and Richard Zemel. "Fairness through awareness." In Proceedings of the 3rd innovations in theoretical computer science conference, pp. 214-226. 2012.

-----

作者沈虹,毕业于美国伊利诺伊大学香槟分校传播学系,现任职于美国卡内基梅隆大学。她用社会学的方法研究新兴科技。

- 报料热线: 021-962866

- 报料邮箱: news@thepaper.cn

互联网新闻信息服务许可证:31120170006

增值电信业务经营许可证:沪B2-2017116

© 2014-2024 上海东方报业有限公司