- +1

当AI开始“说谎”:一场人机之间的博弈才刚刚开始

原创 有思想的一刻君 一刻talks

作者 | Talk君

大家好,我是talk君。

最近一段时间,以DeepSeek为首的AI大模型成为了牛马们手头不可缺少的辅助工具,但是你是否遇到过这样的情况?当你向AI提出一个问题,或是让它协助你撰写一段文案,几秒钟过后,一个看上去内容丰富、逻辑缜密的答案呈现在你面前,可是当你审查时才发现,它竟然是在胡说八道?

这些案例背后,隐藏着一个技术黑话——「AI幻觉」。

啥叫AI幻觉?首先明确下它的定义:

“AI幻觉是指在生成式人工智能模型(如大型语言模型)中,其生成的内容看似合理,但实际上可能与事实不符,甚至完全脱离上下文。这种现象通常表现为生成错误、误导性甚至完全虚构的信息。”

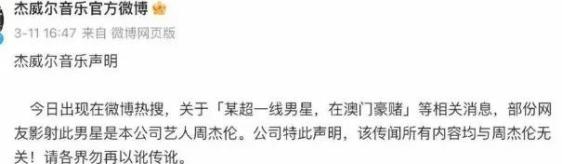

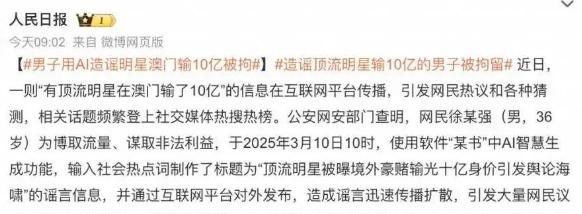

就拿最近的热点来说吧,前两天,一条“有顶流明星在澳门输了10亿”的新闻在网络上引起轩然大波,更是有不少明星出来“自证清白”。

为啥?因为这条消息写的可太“真实”了,于是网友们纷纷开始猜测事件中的主人公是谁……

但万万没想到,这条新闻竟然是用AI编的假消息。

类似的事件还不在少数,比如前两天,我需要写一篇活动新闻稿,我把详细的素材、重点、要求都喂给AI后,它确实用很快的时间就写出了一篇新闻稿。

但看过之后发现,其中30%的内容居然是它瞎编的,甚至活动现场没有出现过的画面也被它写了进去。

而更可怕的是,当人工智能越来越完善,那么其自圆其说的能力也会越来越强,届时,当AI生成错误信息形成传播闭环,并被其他AI当作训练数据,我们的知识体系将如多米诺骨牌一样倒下,而我们每个使用者,都可能成为虚假信息的“二传手”。

AI为什么会产生幻觉?

首先我们可以确定,AI不是要主动欺骗我们,而是它需要用已知的知识来回答我们的问题或是需求,当遇到知识盲区时,它会用自己所理解的方式来完成任务。

这里面,有4个主要原因:

1. 数据偏差:比如训练数据中可能包含错误信息或过时的知识,导致模型学习到不准确的内容。

2. 知识固化:无法动态更新知识,当遇到鲜事物或事件时,他可能会根据旧信息瞎编。(如2025年后政策完全虚构)

3. 算法局限:因为算法的局限性,AI常会生成一些表面看似合理、实则错误的推理与建议。特别是在复杂、需要精准判断的任务中,比如与法律、医疗相关的信息。

4. 幻觉共振:多平台交叉引用形成"信息茧房",倒逼AI将其误判为事实。

普通人如何应对「AI幻觉」?

前两天Manus的创始人肖弘在接受采访时谈到了一个观点,那就是“有没有ai都要掌握溯源的能力”。

这里提到的溯源能力非常关键,下边我列举几个我平时会用到的方法,基本上能够应对90%以上的AI幻觉情况。

1. 联网搜索:现在基本上我们会用到的大模型都有联网功能,这样会使AI实时联网搜索,减少错误概率。

2. 文献提供:当你向AI提完问题或是需求时,不妨在结尾加上一句,“请提供内容对应的文献或数据支持,信息不明确时请务必注明” ,此时AI给出的答案都会携带内容来源,方便你查询真实性。

3. 双重检查:当AI给出答案时,可以将其复制到另一个AI大模型中进行检查审核。

总之,对于所有AI和互联网所提供的信息,我们都要进行反复的交叉验证,这样的溯源能力,是当代数字公民必要的素养。

「AI幻觉」是否一无是处?

当然,其实「AI幻觉」也并非一无是处,如果你的本意就是要构思一个故事或是进行艺术创作,那有时它的一些“幻想”,还是可以给你带来眼前一亮的灵感。

对此,你怎么看?你还有哪些方法能够避免AI“胡说八道”?

欢迎评论区留言讨论~

- END -

原标题:《当AI开始"说谎":一场人机之间的博弈才刚刚开始!AI有多会一本正经地胡说八道?》

本文为澎湃号作者或机构在澎湃新闻上传并发布,仅代表该作者或机构观点,不代表澎湃新闻的观点或立场,澎湃新闻仅提供信息发布平台。申请澎湃号请用电脑访问http://renzheng.thepaper.cn。

- 报料热线: 021-962866

- 报料邮箱: news@thepaper.cn

互联网新闻信息服务许可证:31120170006

增值电信业务经营许可证:沪B2-2017116

© 2014-2025 上海东方报业有限公司