- +1

最强大模型 Llama 3.1 405B 正式发布,开源可媲美闭源了

就在刚刚,Meta 发布了其最先进的开源大语言模型——Llama 3.1 系列,其中就包括首个“前沿级”(frontier-level)的开源模型——Llama 3.1 405B。

据介绍,Llama 3.1 405B 具有强大的灵活性、控制性和最先进的功能,可与 GPT-4o、Claude 3.5 Sonnet 等最优秀的闭源模型相媲美。

此次,Llama 3.1 系列模型将上下文长度扩展到了 128K,并增加了对八种语言的支持。

Meta 表示,他们将通过提供更多与模型协同工作的组件(包括参考系统),继续将 Llama 打造成一个系统,并希望为开发人员提供工具,帮助他们创建自己的定制智能体和新智能体行为。

此外,Meta 也将通过新的安全和保障工具(包括 Llama Guard 3 和 Prompt Guard)帮助开发者负责任地进行开发。

Meta 在在官方博客中写道,“迄今为止,开源大语言模型在功能和性能方面大多落后于封闭的同类产品。如今,我们迎来了一个由开源引领的新时代。我们将公开发布 Meta Llama 3.1 405B,我们相信它是世界上规模最大、功能最强的开放基础模型。”

Llama 3.1 405B 终于来了

Llama 3.1 405B 是首个在常识、可操纵能力、数学、工具使用和多语种翻译等方面媲美顶级闭源人工智能模型的公开发布的模型。

Meta 认为,最新一代的 Llama 将点燃新的应用和建模范式,包括生成合成数据以改进和训练更小的模型,以及模型提炼--这是开源软件从未达到过的能力。

作为最新版本的一部分,他们推出了 8B 和 70B 模型的升级版本。这两个版本支持多种语言,上下文长度大大增加,达到 128K,工具使用 SOTA,整体推理能力更强。这使得 Llama 3.1 系列模型能够支持高级用例,如长文本摘要、多语言对话智能体和编码助手。

值得一提的是,Meta 还修改了许可证,允许开发人员使用 Llama 模型(包括 405B 模型)的输出结果来改进其他模型,并在 llama.meta.com 和 Hugging Face 上向社区提供这些模型的下载。

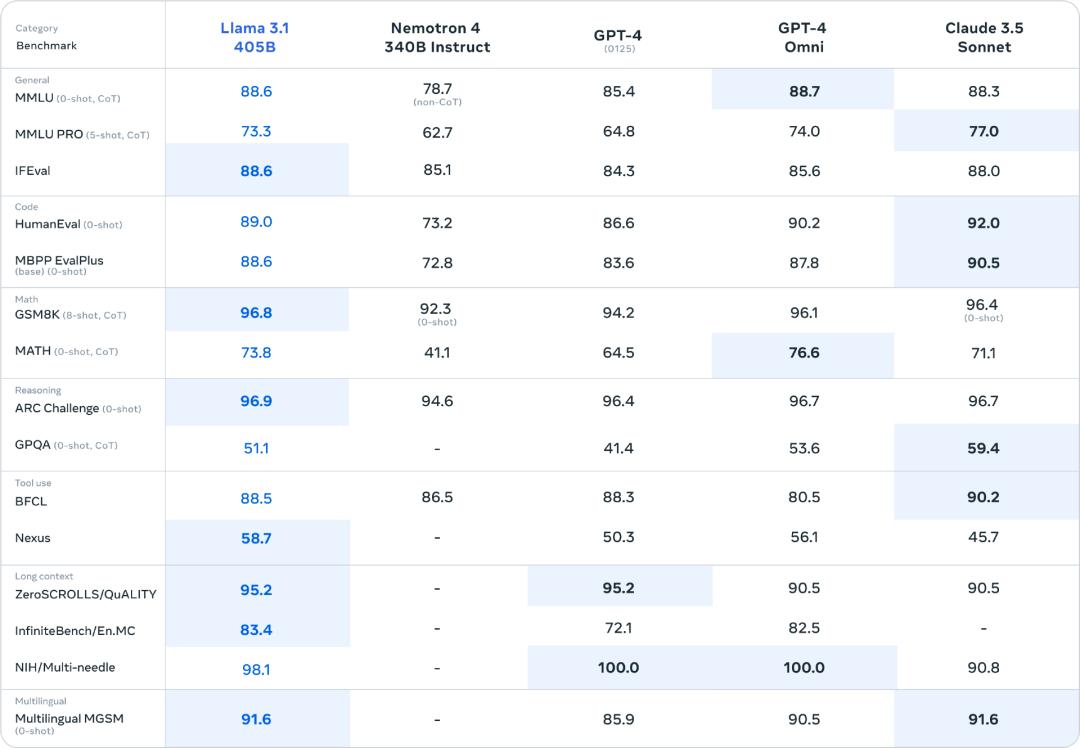

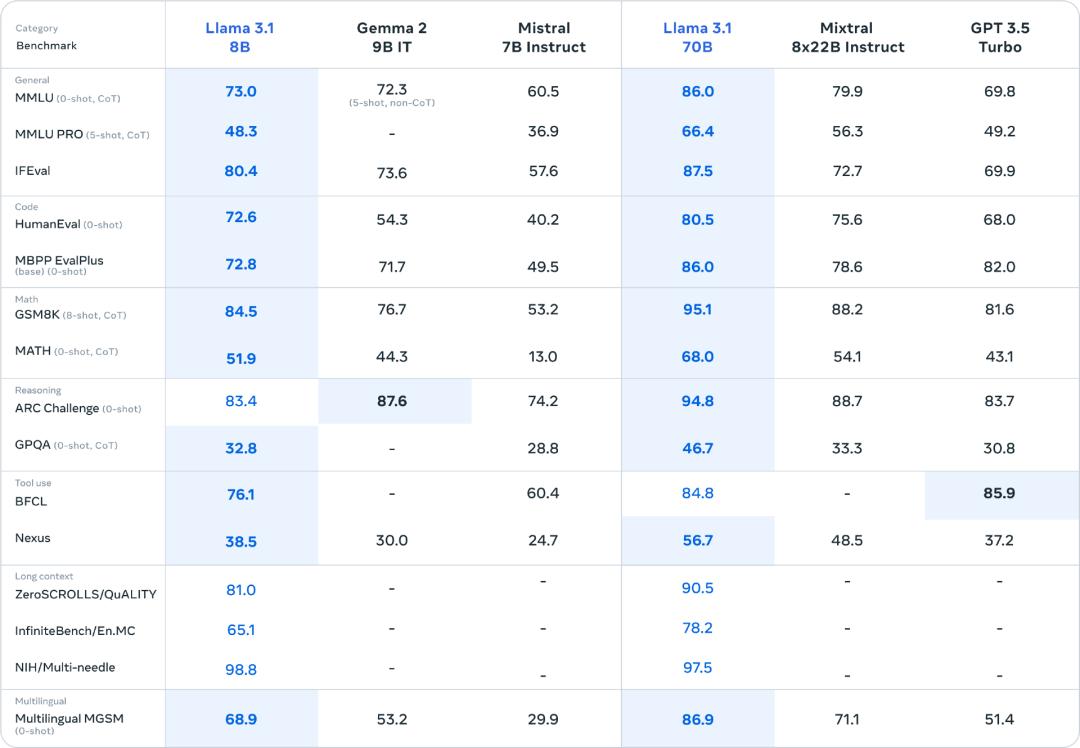

模型评估

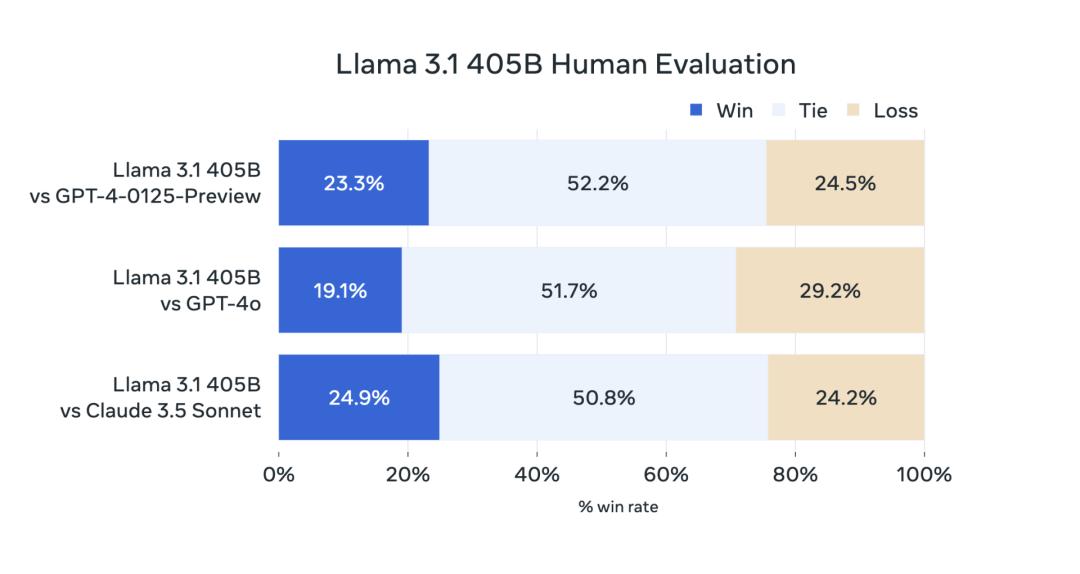

针对 Llama 3.1 系列模型,Meta 评估了 150 多个基准数据集的性能,这些数据集涵盖了多种语言。此外,他们还进行了广泛的人工评估,将 Llama 3.1 与其他竞争模型进行了比较。

实验评估结果表明,Llama 3.1 405B 在广泛的任务中都能与 GPT-4、GPT-4o 和 Claude 3.5 Sonnet 相媲美。此外,Llama 3.1 的小型模型与参数量相近的模型相比也具有竞争力。

模型架构

作为 Meta 迄今为止最大的模型,在超过 15 万亿个 token 上训练 Llama 3.1 405B 是一项重大挑战。为了在合理的时间内完成如此大规模的训练运行并取得这样的结果,Meta 对整个训练堆栈进行了大幅优化,并将模型训练推送到 1.6 万多个 H100 GPU 上,使 405B 成为第一个以如此规模训练的 Llama 模型。

为了解决这个问题,Meta 在设计时选择了保持模型开发过程的可扩展性和直接性(straightforward)。

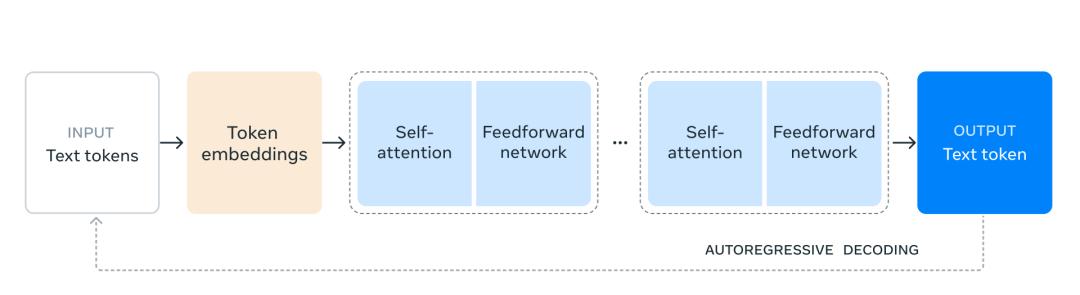

为了最大限度地提高训练的稳定性,他们选择了标准的仅解码器 transformer 模型架构,并作了较小的调整,而没有采用混合专家模型。

他们采用了迭代后训练程序,每一轮都使用监督微调和直接偏好优化。这使得他们能够为每一轮训练创建最高质量的合成数据,并提高每种能力的性能。

与以前版本的 Llama 相比,Meta 改进了预训练和后训练所用数据的数量和质量。这些改进包括为预训练数据开发了更细致的预处理和整理管道,为后训练数据开发了更严格的质量保证和过滤方法。

正如语言模型的缩放规律所预期的那样,Llama 3.1 405B 优于使用相同程序训练的较小模型。他们还利用 Llama 3.1 405B 提高了小型模型的后期训练质量。

为了支持 Llama 3.1 405B 的大规模生产推理,他们将模型从 16 位(BF16)量化为 8 位(FP8)数值,有效降低了所需的计算要求,使模型可以在单个服务器节点内运行。

指令和 chat 微调

在 Llama 3.1 405B 中,Meta 努力提高模型在响应用户指令时的帮助性、质量和详细的指令跟随能力,同时确保高度的安全性,面临的最大挑战是支持更多的功能、128K 上下文窗口和更大的模型尺寸。

在后期训练中,他们通过在预训练模型的基础上进行多轮对齐来生成最终的聊天模型。每一轮都包括监督微调、拒绝采样和直接偏好优化。

他们使用合成数据生成技术来生成绝大多数 SFT 示例,并进行多次迭代,以在所有功能中生成质量越来越高的合成数据。

此外,他们还使用了多种数据处理技术,以过滤最高质量的合成数据。这使得他们能够在各种能力之间扩展微调数据量。

他们还仔细平衡数据,以在所有功能中生成高质量的模型。例如,即使扩展到 128K 上下文,他们也能在短上下文基准上保持模型的质量。同样,即使增加了安全缓解措施,Llama 3.1 系列模型也能继续提供最有帮助的答案。

开放推动创新

Meta 在官方博客中写道,与封闭的模型不同,Llama 模型权重可供下载。开发人员可以完全根据自己的需求和应用定制模型,在新的数据集上进行训练,并进行额外的微调。这使得更广泛的开发者社区和全世界都能更充分地发挥生成式人工智能的能力。开发人员可以根据自己的应用进行完全定制,并在任何环境中运行,包括预置环境、云环境,甚至是笔记本电脑上的本地环境,而无需与 Meta 共享数据。

Meta 也表示,虽然很多人可能会认为封闭模型更具成本效益,但根据 Artificial Analysis 的测试,Llama 模型的单位 token 成本在业内最低。

正如 Mark Zuckerberg 所指出的那样,开源将确保全世界更多的人能够享受到人工智能带来的好处和机会,确保权力不会集中在少数人手中,确保这项技术能够在全社会范围内得到更均衡、更安全的部署。

本文为澎湃号作者或机构在澎湃新闻上传并发布,仅代表该作者或机构观点,不代表澎湃新闻的观点或立场,澎湃新闻仅提供信息发布平台。申请澎湃号请用电脑访问http://renzheng.thepaper.cn。

- 报料热线: 021-962866

- 报料邮箱: news@thepaper.cn

互联网新闻信息服务许可证:31120170006

增值电信业务经营许可证:沪B2-2017116

© 2014-2024 上海东方报业有限公司