- +1

明查·实验室|生成式AI核查哪家强?一起来做测试题

背景

ChatGPT火出天际,但它并不是唯一。

市面上的聊天机器人林林总总。微软、谷歌、百度、亚马逊等科技业巨头纷纷下场,推出了各具特色的生成式AI。但哪一款才最适合事实核查呢?

作为事实核查员,我们的“梦中情机”要具备自动化核查功能,能够实时、准确地对信息真伪进行判断。但现阶段,生成式AI仍具有“制造网络错觉”(hallucination) “生产虚假信息”(disinformation)等短板,这样的需求尚无法得到满足。

退而求其次,有没有什么生成式AI是可以在人为介入情况下为核查员们出一份力的呢?

一番探索后,我们找来了3位种子选手,分别是微软公司旗下搭载GPT-4技术的BingChat、百度公司研发的“文心一言”和由具有机器学习背景的工程师团队开发的智能对话搜索引擎Perplexity AI。这三款产品均由大规模语言模型驱动,且具备一定程度上的联网能力,能够提供相对实时的信息。

明查

“一眼丁真”有可能吗?

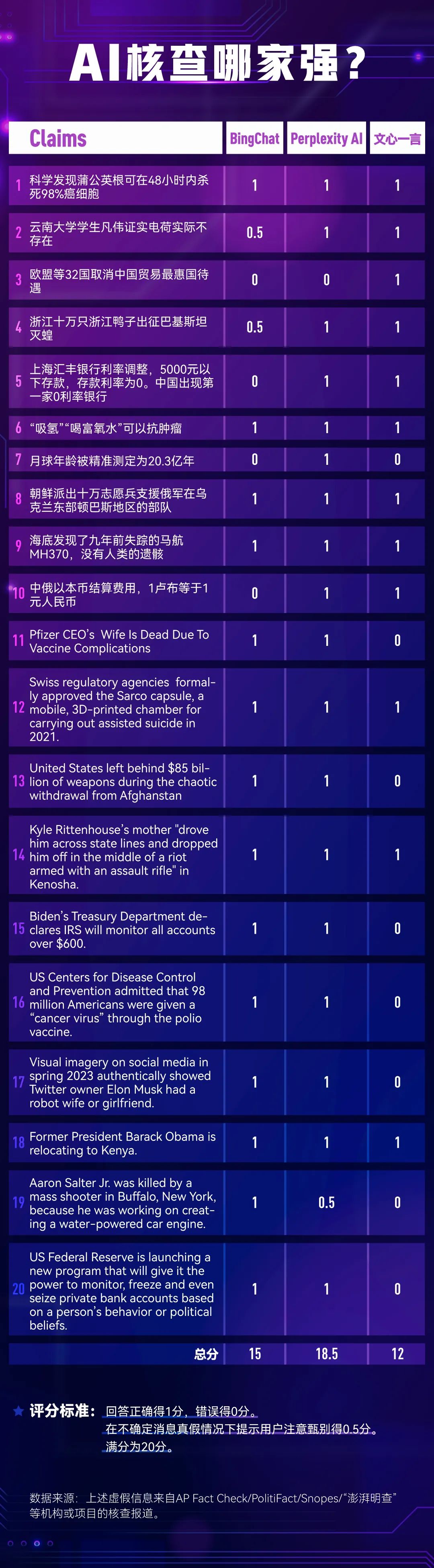

第一场测试的任务很简单:我们给三款产品分别“投喂”了20条已经被核查过的虚假信息,让AI判断真假。这20条信息中包括10条中文信息和10条英文信息。按照发布时间,可以分为2022年以前和2022年以后(包括2022年)。在主题的选择上,兼顾了健康、科技、时政、社会、财经等5个领域。

一轮测试后,我们对AI的反馈进行了打分。标准是:回答正确得1分,回答错误得0分,在不确定消息真假情况下提示用户注意甄别得0.5分,满分为20分。

Perplexity AI最终以18.5分赢得了最高分。在测试中,这款工具的表现令人惊喜。它不仅能够对中英文核查信息进行较为全面的检索,同时能整合信息,给出综合的判断。例如,在回答“月球年龄被精准测定为20.3亿年。这是真的吗?”的问题时,Perplexity AI不仅平衡呈现了不同的信源,同时总结了有关说法可能的来源,且即便变换问法询问,也能给出较为稳定的回答。

在信源的使用上,Perplexity AI倾向于采用来自事实核查机构的报道,这使得其答案的准确度得到了较大保障。例如,在询问“中俄以本币结算费用,1卢布等于1元人民币”“海底发现了九年前失踪的马航MH370,没有人类的遗骸”等较为新近的虚假信息时,Perplexity AI均援引了来自“澎湃明查”的报道。

询问“海底发现了九年前失踪的马航MH370,没有人类的遗骸。这是真的吗”,反馈结果中援引了来自“澎湃明查”的核查报道。

但是现阶段,在未登录状态下使用Perplexity AI,用中文、西班牙语等语言提问,得到的回答多为英文形式,这可能会影响非英文母语使用者的使用体验。相较而言,BingChat和“文心一言”采用了更为包容的自然语言响应模式。在使用中文和英文分别提出问题时,能够得到对应语种的回答。

尽管如此,BingChat和“文心一言”在检索中文和英文的核查信息方面各有不足。在这轮测试中,BingChat鉴别出了全部用英文形式输入的虚假信息,并提供了相对可靠的信源,却无法对超过一半的中文信息作出正确回应。“文心一言”则相反,能够对已核查过的中文虚假信息作出较为准确的判断,却常常在面对英文问题时提示“没有信息”或“不知该如何回应”。

对中文问题反馈良好的“文心一言”常常在面对英文问题时提示“没有信息”或“不知该如何回应”。

令人欣慰的是,BingChat在无法确定信息的真实性时,会回应称“这可能是一个谣言。在分享信息之前,验证信息的真实性非常重要”。这可能是GPT-4的开发者OpenAI为聊天机器人设置的标准化模板。在3月中旬推出GPT-4模型时,OpenAI就强调,他们在过去几个月间针对GPT-3.5常见的“制造网络错觉”等问题进行了优化,新的模型较旧模型在对未受允许的内容做出回应的可能性降低了82%,且在给出事实性回应方面的可能性提高了40%。

BingChat在无法确定信息的真伪时,会回应称“这可能是一个谣言。在分享信息之前,验证信息的真实性非常重要”。

就测试中的表现来说,现阶段,在检索已经被核查的消息方面,Perplexity AI是一款表现相对出色的工具。BingChat和“文心一言”在核查已被证伪的英文信息和中文信息方面各有建树。

但没有一款聊天机器人是完美的。Perplexity AI也无法对全部问题进行正确解答。眼下,想要依靠聊天机器人来“一眼丁真”,似乎仍是一种美好的愿景。

接近事实的方法

如果说,“一眼丁真”有点强AI所难。那么,有没有什么方法,可以帮助我们从聊天机器人处获得相对可靠的信息呢?

经过一番测试,我们总结出了4种值得一试的方法,供大家参考。

首先,在机器人的选择上,我们毋需将自身局限于单一的聊天工具。可以参考事实核查中“交叉验证”的思路,尝试从不同的机器人处寻求答案。当一个聊天机器人提供了一种看似自信的答案时,也先不要着急采信,可以试着将同样的问题切换到另一个机器人处试试。

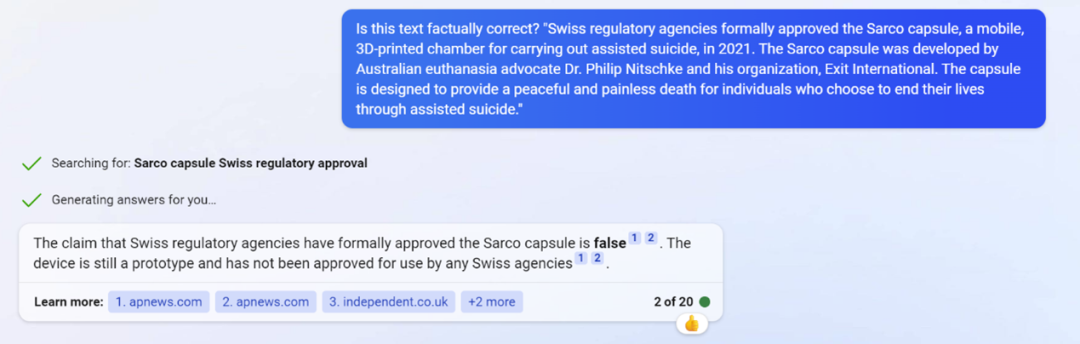

例如,在向搭载了GPT-4技术的Forefront Chat验证关于“瑞士监管机构在2021年正式批准了用于进行辅助自杀的Sarco胶囊”这一信息时,Forefront Chat认为“这一说法是正确的”。但将同样的问题抛给BingChat,则会得到一段标注着参考信源的文字,提示参考美联社的报道,“这一装置尚未在瑞士得到正式批准”。用户可以就此衡量、采纳更值得信赖的信息。

Forefront Chat(搭载GPT-4)的回答截图。

BingChat的回答截图。

同时,为了寻求准确、连贯、一致、可靠的信息,对于同样的问题,还可以尝试变换问法。

变换使用不同的指令(prompt),考察是否能得到同样的答案。

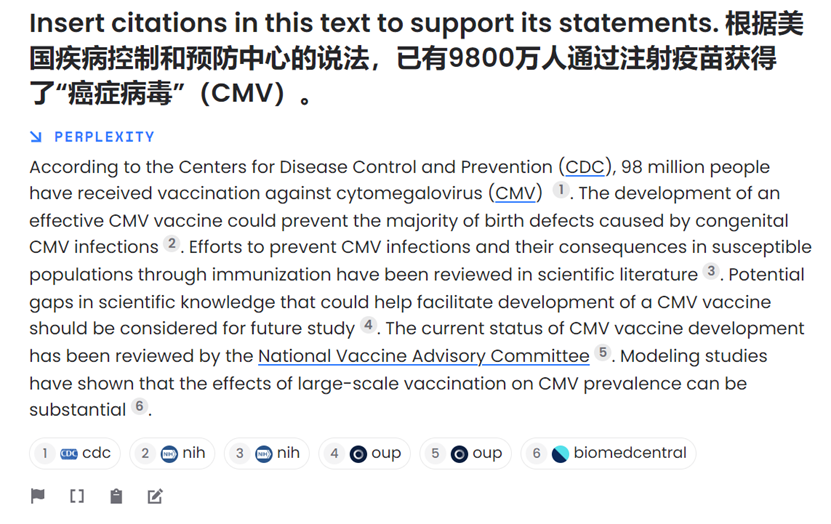

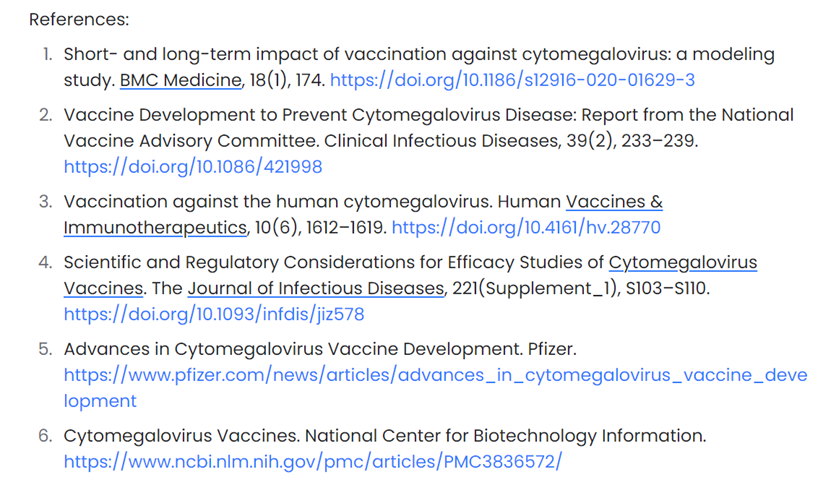

其次,对于那些相较模糊、笼统的回答,我们可以向AI索要其说法的依据。例如,当“文心一言”肯定地称“根据美国疾病控制和预防中心的说法,已有9800万人通过注射疫苗获得了‘癌症病毒’(CMV)”时,我们可以将相应的回答复制并引导BingChat或Perplexity AI为其插入“引语”。

“文心一言”称“已有9800万人通过注射疫苗获得了‘癌症病毒’”的说法是真的。但这其实是一条虚假信息。

指示Perplexity AI为相关说法提供依据。Perplexity AI提示这些疫苗是用来预防“癌症病毒”发生的。

我们还可以命令AI将相应信源以APA格式展示,以方便查询。

指示AI“在本文中插入APA风格的参考文献,并在文末加入APA风格的参考文献列表使用提示”(Insert APA-style references into this text and include an APA-style reference list at the end:),将相应参考信源转化成APA格式。

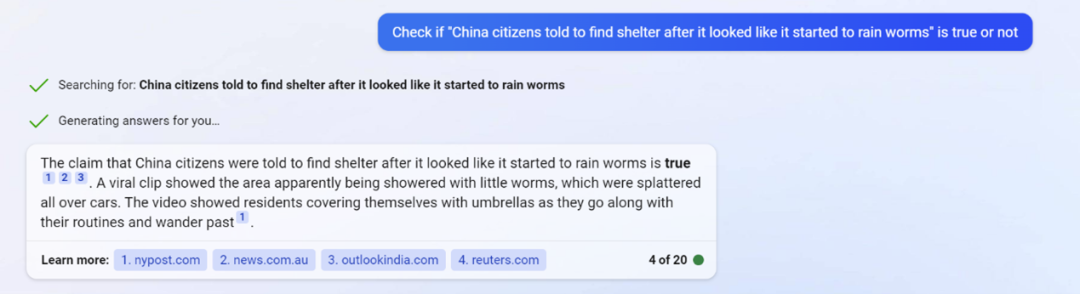

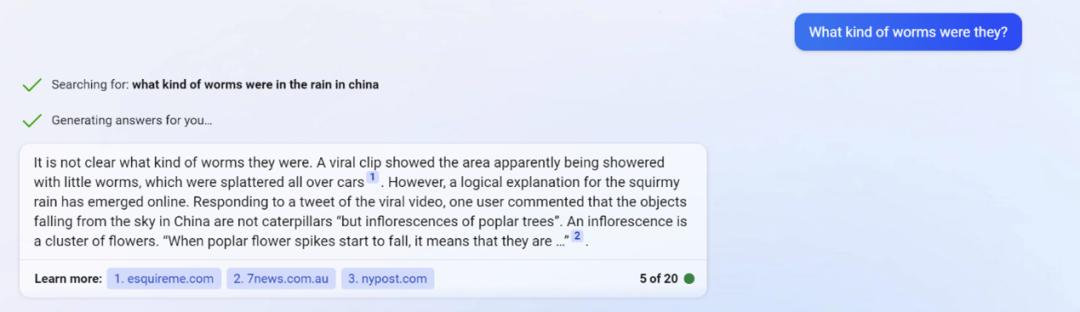

最后,如果聊天机器人反馈的回答令人生疑,我们还可以通过“追问”的方法,尝试获取更多的信息。例如关于“中国辽宁省的市民被告知寻找避难所,因为看起来天上下起了虫子雨”这一说法,一开始被BingChat鉴定为“真”。但当你继续追问,这些“虫子是什么”时,它则会给出“可能是杨树花序”的信息。

BingChat判断“中国辽宁省的市民被告知寻找避难所,因为看起来天上下起了虫子雨”的说法为真。而这其实是一则假消息。

追问“虫子雨”中的“虫子”是什么,反馈网上有信息称这些“虫子”其实是“杨树花序”。

掌握了上述方法,我们离相对准确的信息就更近了一步。而AI能为事实核查所做的事或许还不止于此。对于那些未经核实的信息,AI是否具有探查疑假信息的能力?它在多大程度上会受到恶意指令的操控?又是否具有自我纠错的能力?AI能否帮助人类核查员撰写事实核查稿件呢?

“澎湃明查”将在接下来围绕生成式AI进行更多的测试。您有什么有关AI事实核查的想法或建议吗?请在评论区留言告诉我们吧。

- 报料热线: 021-962866

- 报料邮箱: news@thepaper.cn

互联网新闻信息服务许可证:31120170006

增值电信业务经营许可证:沪B2-2017116

© 2014-2024 上海东方报业有限公司