- +1

赛迪智库|对比美欧人工智能法案,兼顾技术创新与安全监管

2021年4月欧盟委员会出台《人工智能法案》(以下简称《法 案》),2022年10 月美国白宫发布《人工智能权利法案蓝图》(以下简称《蓝图》),两者均把人工智能安全建设作为法案的核心内容。赛迪研究院未来产业研究中心通过对比研究认为,中国要进一步完善人工智能治理体系,制定有关规制措施和细则,可借鉴 美欧人工智能法案方面的新举措,比如算法源头的公平性管理、分类分级风险管控措施及完善的治理规则。

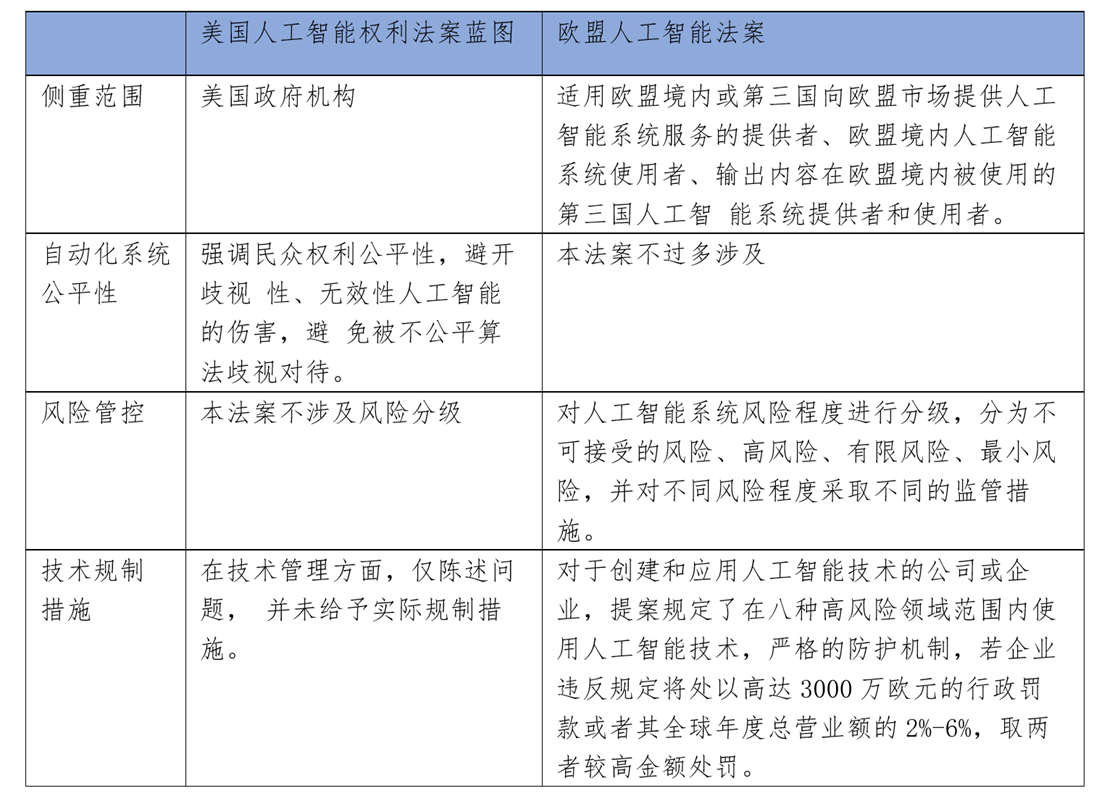

一、美欧法案各有侧重,前者更重公平隐私,后者更重风险管控

美国《人工智能权利法案蓝图》核心内容为五项基本原则,将公平和隐私保护放在首要位置。《蓝图》提出的五项基本原则包括:建立安全和有效的系统;避免算法歧视,以公平方式使用和设计系统;保护数据隐私;系统通知和解释要清晰、及时和可访问;设计自动系统失败时使用的替代方案、考虑因素和退出机制。这五项基本原则旨在避免人工智能系统滥用带来的危害,并着重强调了公平性和隐私性。在公平性方面,《蓝图》要求自动化系统的设计者、开发者和部署者应采取积极措施,保护个人和社区免受算法歧视, 并以公平的方式使用和设计系统。在隐私保护方面,《蓝图》提出,数据隐私是实现该框架中其他原则所需的基础性和交叉性原则。同时,《蓝图》要求自动化系统的设计和构建应默认保护隐私,数据收集和使用范围应有确定目标。

欧盟《人工智能法案》是首个针对人工智能风险管控的法案。《法案》基于风险预防理念,为人工智能系统制定了覆盖全过程的风险规制体系,是全球首个针对人工智能风险规制的法案。在风险流程监控方面,《法案》鼓励建立国家或欧盟层面的监管沙盒,进一步规范处理合法收集的个人数据,并制定了相关规则。就风险防范措施而言,《法案》将人工智能系统划分为不可接受风险、高风险、低风险和最小风险四类,着重立法规制前两类风险,对高风险人工智能系统的全生命周期监管作了详细规定。在适用范围方面,《法案》将高风险覆盖的领域归纳为关键基础设施、公民教育、产品的安全组件、公民就业、公共服务、涉权型执法、出入境问题、司法和民主进程八类,重点提出,远程生物识别系统原则上禁止在公众可进入的空间和场所内使用。

表1 美欧人工智能法案主要内容对比

综合来看,美国的《蓝图》虽未提出明确规则举措,但已将公平和隐私保护视为法案的核心宗旨,后续细则也将围绕强化公平和隐私保护展开。欧盟《法案》则首次在人工智能风险管控方面制定了实施细则,分场景、分级别的监管措施给完善治理体系提供了操作路径。

二、几个启示

规制措施应进一步明确细化。美国《蓝图》提出了五项基本原则,但只限于“行动呼吁”,并未给出实际规制措施。目前,中国人工智能治理体系也未明确和细化实施措施。具体而言,中国人工智能治理体系主要涉及《网络安全法》《个人信息保护法》《数据安全法》等法律条例,分别对网络运营商和个人敏感信息以及数据处理的安全监管保护做了详细规定,但在法律层面,对人工智能系统和算法的公平性尚未有明确规定,治理方案缺失。出于填补上述空白、进一步规范和细化人工智能治理体系的考虑, 中国应及时出台人工智能相关规则,强化管控风险,推动人工智能产业健康发展。

风险管控措施应注重事前-事中-事后全流程管理。欧盟《法案》 在立法方面的“事前-事中-事后”全链条监管机制值得中国借鉴。在事前阶段,法案划分为四种风险等级,根据应用场景及风险等级的不同,制定相应规制措施。在事中阶段,《法案》引入监管沙盒机制,一旦发现给人的健康、安全和基本权利带来风险时,会立即采取措施降低风险。在事后阶段,《法案》规定高风险人工智能系统供应商应制定售后监测计划和售后监控系统,有义务及时将违规事件或严重故障系统上报国家监管机构。目前中国在人工智能风险管控措施方面还存在空白,可考虑借鉴《法案》框架及实施经验,制定适用于中国的人工智能风险管控措施。

提防过度重视公平性与风险管控束缚产业创新活力。值得注意的是,美欧人工智能法案将公平性和风险管控置于高优先级,对产业创新发展欠缺应有的重视。当前,中国人工智能产业已进入规模化应用落地爆发期,算法争议和系统安全事件偶有发生,人工智能治理体系的健全完善已进入有关主管部门的工作日程。有关主管部门在制定人工智能相关规制措施时,应合理把握规制措施的管控力度,做到完善人工智能治理体系和提升产业创新活力并举。

三、对策建议

加快完善算法公平性管理相关条例。一是立足算法监管,明确从源头抓起的基本出发点,引入公平性约束、算法可解释性等原则要求,规范算法监管的手段和范围。二是确立可追溯性原则,将算法行为决策置于监管范畴,确保案例调查中可还原追溯算法执行过程,对算法不当之处强制要求修正。三是重点关注算法在人工智能系统中的设计、开发与部署,要求系统开发设计人员明晰算法在人工智能系统中的运用。

加快制定分类分级风险防范措施。一是建立健全人工智能系统风险管控的“事前-事中-事后”全链条监管新机制。事前阶段,在人工智能产品流入市场前进行风险评估,实现风险管控;事中阶段,持续性进行市场监督,实施产品召回制度;事后阶段,进行总结分析,实现人工智能风险事故的数据共享和风险监测。二是根据风险场景制定有层次、有梯度的风险等级管控机制。对归属于同一风险场景中的人工智能系统进行统一风险管控,建立起场景明确、等级清晰,自下而上限制逐步加深的“风险金字塔”模型的监管细则。三是加大违规处罚力度。明确人工智能系统开发企业或独立开发者运用算法的风险防范红线,对风险防范违规行为给予严格惩治,增强监管措施的强制约束性。

推动技术创新和安全监管并重并行。一是采取包容审慎的原则,针对人工智能创新应用场景和技术采取“沙盒监管”等创新监管手段,创新与监管同时推进,在“试验田”内摸索监管尺度、范围和手段,迭代试点经验,形成较为成熟的制度化措施。二是推动安全监管技术创新。设立人工智能安全技术创新平台,推进人工智能安全核心技术攻关,建设人工智能安全创新中心,加快安全监管与技术创新融合发展。三是引导人工智能权威第三方行业机构和龙头企业,健全人工智能算法和系统行业自律规范,建立健全执业诚信体系,更好地发挥社会监督作用。

(作者钟新龙、彭璐均来自赛迪研究院未来产业研究中心)

- 报料热线: 021-962866

- 报料邮箱: news@thepaper.cn

互联网新闻信息服务许可证:31120170006

增值电信业务经营许可证:沪B2-2017116

© 2014-2024 上海东方报业有限公司