- +1

AAAI 2023|基于多模态标签聚合的视频检索模型TABLE,多项SOTA

机器之心专栏

QQ 浏览器搜索技术中心、腾讯 PCG ARC Lab

近年来,互联网短小视频内容的爆发式增长,对视频 - 文本检索(Video-Text Retrieval)的能力提出了更高的要求。在 QQ 浏览器搜索中,视频通常包含标题、封面图、视频帧、音频等多种模态信息,因此视频检索模型引入了多模态特征,以刻画 query 与视频在多个模态上的相关程度,并进行综合排序,提升视频搜索结果的整体满意度。此外,QQ 浏览器还能根据用户正在观看的视频内容,推荐用户可能感兴趣的搜索词,推词的挖掘、排序同样需要模型对视频多模态信息的有效利用。

在学术界,目前视频检索有两种主流模型:

基于 CLIP 图文预训练的模型:代表工作为 CLIP4Clip,优点是成功地将图文预训练的知识迁移到视频 - 文本检索的任务中,不足是缺乏对视频其他模态信息的利用;

基于多模态信息编码的模型,代表工作为 MMT(Multi-Modal Transformer),优点是使用 transformer 将视频的多种模态信息(物体、动作、场景、音频等)进行联合编码;不足是将分布差异巨大的多模态特征(embedding)输入到一个黑盒(black box),不仅无法做到有效融合,也增加了模型训练的难度。

由此,我们提出了一种既学习了图文预训练知识,又有效利用多模态标签引导视觉 - 文本对齐的视频检索模型:TABLE(TAgging Before aLignmEnt)。

TABLE 模型在四个视频 - 文本检索的公开数据集上取得了 SOTA 的效果,相关研究已经被 AAAI 2023 录用。

TABLE 的优势

视频 - 文本检索是人工智能领域非常重要的任务之一,任务关键在于视觉信息与文本信息在同一语义空间上的对齐。近年来,随着大规模预训练模型的提出,视频检索模型的性能得到了显著提升。但当前大多数模型(如 CLIP4Clip、CLIP2VIDEO 等)只使用视觉模态进行检索召回,视频其他模态的信息没有得到有效利用,因此召回的结果不管是在相关性还是多样性上,都是有所欠缺的。

一些方法(如 MMT、MDMMT 等)尝试使用多种任务上的预训练模型(experts)提取多模态的 embedding,再用 transformer 结构对 embedding 进行融合。然而不同 experts 提取的 embedding 分布差异是巨大的,因此很难通过一个简单的模块就能完成多模态信息的融合。再者,这种黑盒融合的方式难以解释,无法得知最终的输出结果是否真的代表了多模态信息,还是只是引入了一些 “可学习的随机输入”。

针对以上问题,我们提出了一个新的以多模态标签为引导的视频 - 文本检索模型:TABLE(TAgging Before aLignmEnt) 。TABLE 模型首先提取视频各个模态的信息,在标签域进行融合,融合的多模态标签最终作为 anchor 促进视觉 - 文本的语义对齐。

我们使用多种预训练 experts 模型进行多模信息的提取,包括物体、人物、场景、动作以及音频。物体和人物信息聚焦视频的局部或实体特征;场景信息则关注视频的整体、背景特征;动作信息是视频区别于图像的重要特征,其中包含的时序信息往往容易被忽略;音频信息则提供了一些视觉以外的辅助信息。

为有效、高效地融合不同模态的信息,我们使用标签域作为融合的桥梁,主要有以下两点优势:

不同 experts 生成的 embedding 难以互相融合,而标签域的方式可以为不同模态信息生成统一、易解释的表征。

多模态标签作为 anchor,可以迫使模型综合学习视频的局部特征、全局特征、时间特征以及其他补充特征。视频的重要片段(时间)以及重要区域(空间)在多模态标签的作用下得到凸显,视频 - 文本召回的整体效果便可以有所提升。

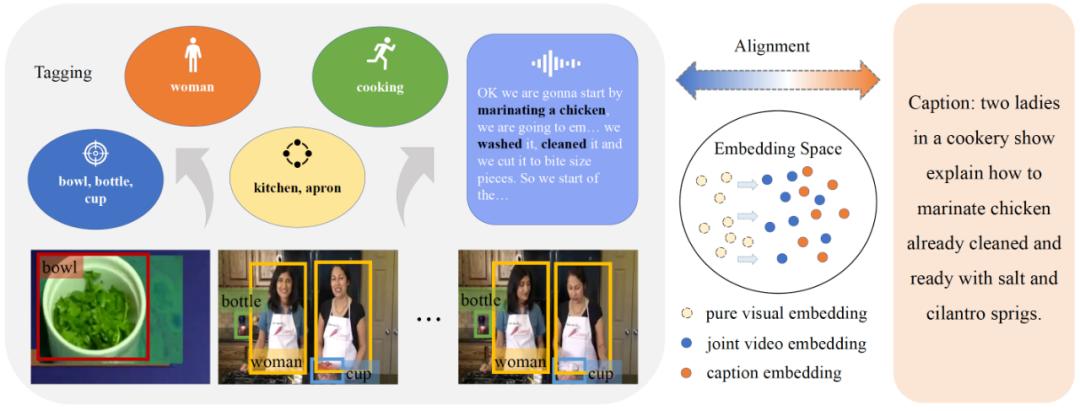

如图一,通过目标检测器,可以得到 "bowl、bottle" 等物体标签以及 "woman" 的人物标签;通过图像分类器,可以得到 "kitchen" 的场景标签;通过动作检测器,可以得到 "cooking" 的动作标签;最后,通过自动语音识别(Automatic Speech Recognition)以及关键词提取,可以得到 "marinating a chicken" 等音频标签。上述标签提供了来自视频多个模态的丰富信息,作为视觉与文本之间交互的桥梁,可以使得对齐学习更加精确和高效。

图一:多模态信息可以转化为标签促进视频 - 文本的对齐。

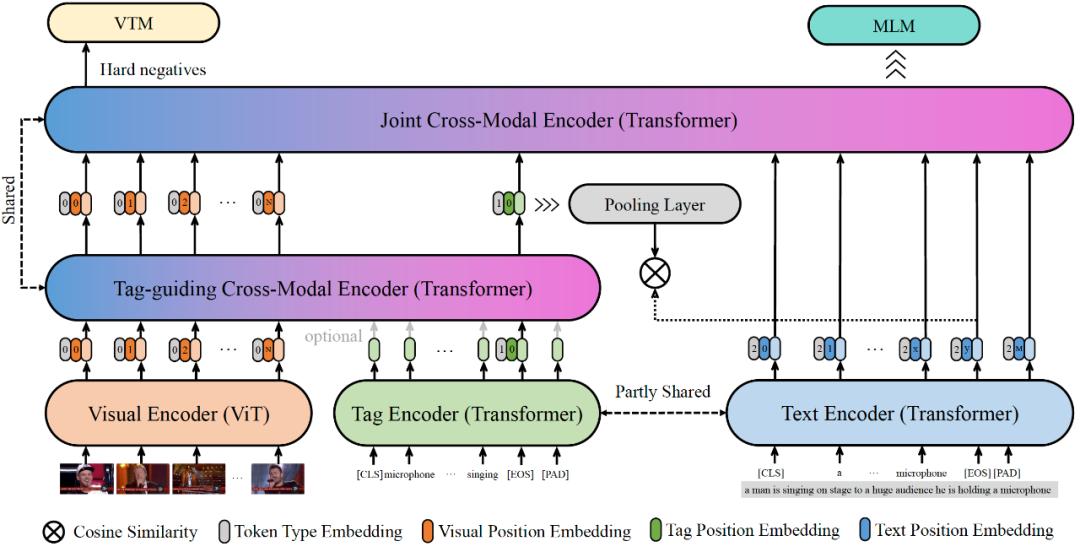

如图二,TABLE 模型包含四个编码器:视觉编码器、标签编码器、文本编码器以及跨模态编码器。其中,跨模态编码联合编码多帧的视觉特征以及多模态的标签特征,多模态标签作为视觉 - 文本对齐的 anchor。此外,我们在模型训练时引入了视频文本匹配损失(Video Text Matching Loss,VTM)和掩码语言模型损失(Masked Language Modeling,MLM)作为额外监督。相比以往方法,TABLE 的优势可以总结如下:

不仅将图文预训练的知识迁移到视频 - 文本检索任务,而且充分利用了视频的多模态信息,包括物体、人物、场景、动作、音频;

多模态信息在标签域上进行融合,得到了统一的表征,可解释性强,并且可以作为 anchor 促进视觉与文本在语义空间上的对齐;

对视频多帧以及多模态标签进行联合编码,并引入了 VTM 和 MLM 任务加强视觉 - 文本更细粒度的交互;

在 MSR-VTT、MSVD、LSMDC 和 DiDeMo 四个常用的视频检索数据集上取得 SOTA 的效果。

图二:TABLE 模型的整体框架

模型细节

1、多模态标签挖掘

TABLE 采用多种预训模型用于提取视频的多模态信息,如表一所示。为了尽可能地减小噪声,每个模型中只有高置信的标签得到保留。

表一:标签挖掘中使用的具体模型

2、视觉与标签、文本编码器

视觉编码器:采用 CLIP 中的 ViT 模型进行初始化。视频帧序列表示为:

,则视觉编码器的输出可以表示为:

,N 表示视频帧的数量。

标签、文本编码器:使用 CLIP 模型中的 BERT 模型进行初始化,两个编码器的 transformer 部分是共享参数的,但是线性投影层是相互独立的。标签、文本编码器的输出可以分别表示为:

,K 和 M 分别表示标签、文本的 token 长度。

3、跨模态编码器

如图二,我们构建了一个以标签为引导的跨模态编码器。编码器的输入可以表示为:

,其中

表示标签编码器在 [EOS] 处的输出,作为多模标签的整体表征。跨模态编码器包含四层的 transformer 结构,采用 CLIP 文本编码器的前四层进行初始化。跨模态编码器对视觉信息和标签信息进行了深度融合,同时由于视频帧的有序输入,模型还可以学习视频的时序信息。其中,标签信息作为引导,可以从嘈杂的视觉特征中筛选出重要的视频帧与视觉区域。跨模态编码器的融合输出可以表示为:

,然后我们采用池化层和残差连接的方式,得到跨模融合的整体表征:

,

是一个可学习的权重因子。

文本编码端取 [EOS] 处的特征作为标题的整体表征,

。我们定义一个视频 - 文本的相似函数:

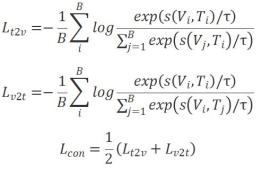

为线性投影函数。最后,我们可以构建损失函数:

是一个可学习的温度系数;B 是训练批次大小;

分别代表文本到视频、视频到文本的对比损失函数;

是整体的对比损失。

4、额外监督

视频文本匹配损失(VTM):将跨模态编码器的输出作为视频的整体表征,判定其与文本编码器的输出是否相匹配。视频的整体表征与文本特征同时输入到一个联合编码器中做进一步的融合,联合编码器与跨模态编码器是共享参数的,在推断时舍弃。取跨模态编码器的首位特征

作为视频的整体表征,文本特征为

,预测的结果为

,则 VTM 的损失函数为:

t=0 表示正样本对,t=1 表示负样本对;

是一个符号函数,当 t=1 时值为 1,否则为 0;

为样本对数。此处进行了难例挖掘,即相关性打分较高的负样本有更大的概率被采样。

掩码语言模型损失(MLM):根据视频的整体表征以及标题上下文,预测标题中被遮挡的单词。

表示受遮挡的文本,

表示遮挡单词的预测结果,则 MLM 的损失函数为:

是一个符号函数,当第 i 个样本的遮挡单词为 v 时,值为 1,否则为 0;V 是词表大小;Q 为样本数量。

TABLE 模型的总体损失函数:

实验评估

1、评估数据集:

MSR-VTT、MSVD、LSMDC、DiDeMo。

2、评估指标:

R@K:Recall at rank K,K=1,5,10,TOP-K 召回结果中包含正确结果的比例;

MdR:Median Rank,正确结果的排序中位数;

MnR:Mean Rank,正确结果的排序平均数。

3、与 SOTA 的性能对比

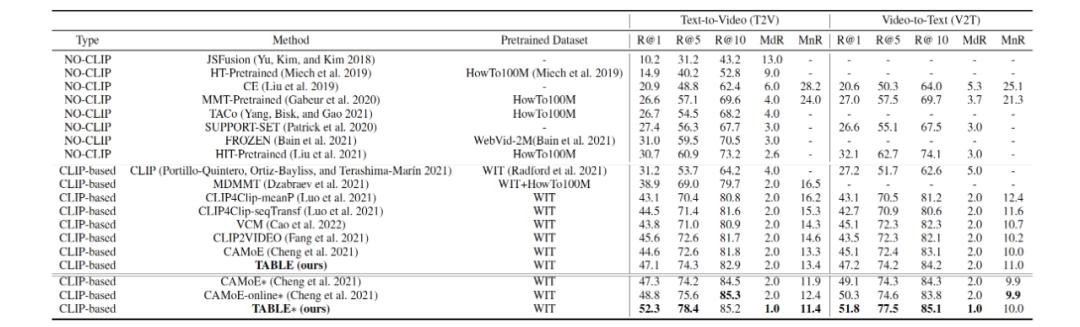

随着 CLIP 等大规模预训练模型的提出,视频检索模型的性能也实现了较大的突破。因此,在进行性能对比时,我们将现有方法分为 CLIP-based 和 NO-CLIP 的方法,可以看出,CLIP-based 的方法通常都会有更好的性能。例如,MMT 在 text-to-video 任务上的 R@1 仅为 26.6,而 CLIP4Clip 可以达到 43.1。

表二:MSR-VTT 数据集上的性能对比,* 表示使用了 CAMoE 中提出的推理策略。

如表二,TABLE 模型在 MSR-VTT 数据集上的表现超过了所有方法,取得了 SOTA 的效果。使用推理策略后,TABLE 在 text-to-video 任务上取得了 52.3 的 R@1,显著提升了视频检索的效果。

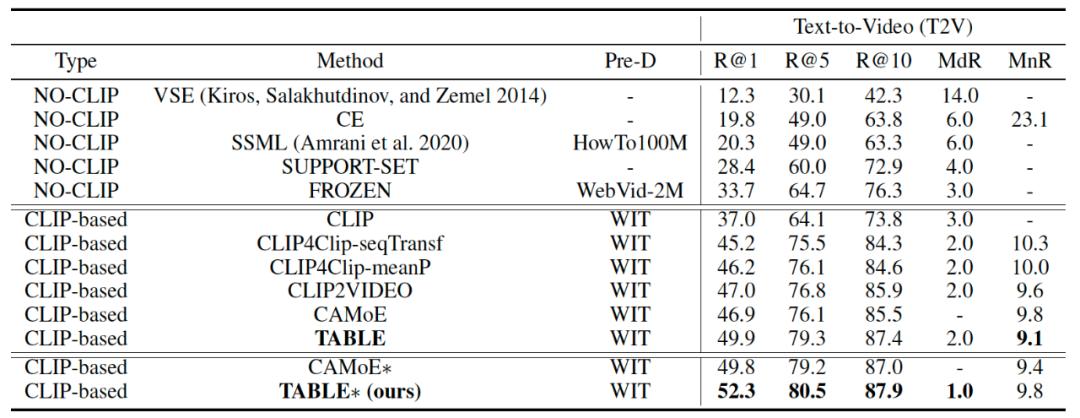

表三:MSVD 数据集上的性能对比

如表三,TABLE 在 MSVD 数据集上同样取得了 SOTA 的效果。我们认为在小样本数据集上的训练学习中,多模标签的引导作用更为重要。

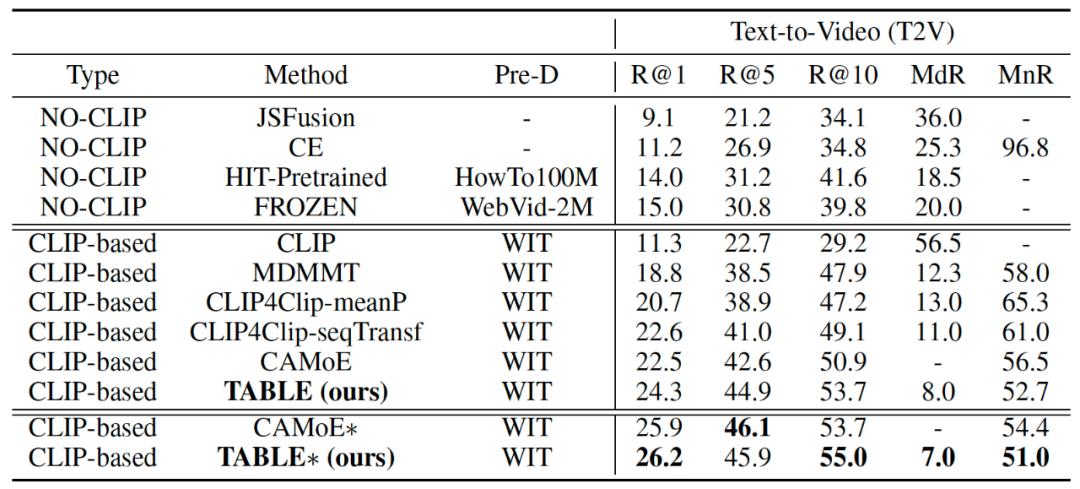

表四:LSMDC 数据集上的性能对比

LSMDC 数据集中包含了最多的视频,且每个视频只对应一个文本,因此大多数方法的表现都较差。TABLE 在这个数据集上稍微提升了一些分数,如表四所示。

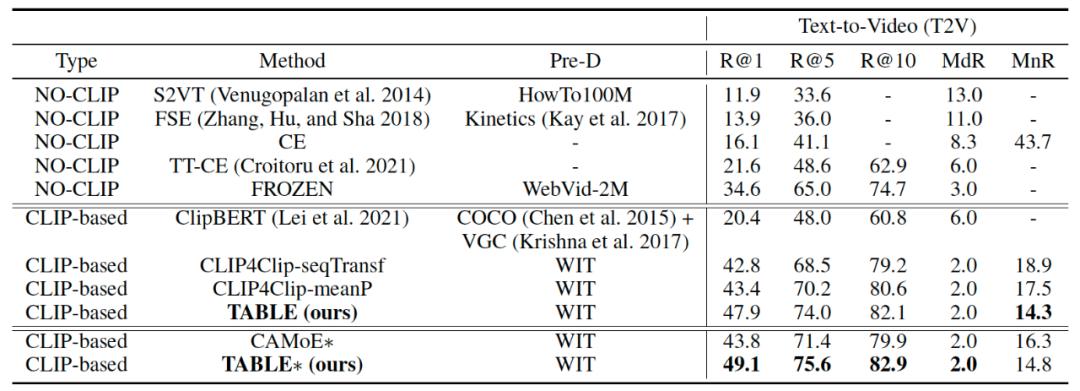

表五:DiDeMo 数据集上的性能对比

在 DiDeMo 上,与其他方法一致,我们进行的是视频 - 段落检索任务,即将一个视频对应的所有文本拼接为一个长文本。如表五,TABLE 在 text-to-video 的 R@1 指标上取得了 5.3 个百分点的显著提升。该数据集的难点在于长视频 - 长文本的对齐,这是因为长视频包含很多无意义的片段,需要从中挑选有意义的帧和区域,而长文本中同样需要找到关键句、关键词。而 TABLE 模型中,多模态标签就相当于一个对齐的 anchor,跨模态编码器可以根据多模态标签从复杂的视觉信息中凸显出重要的视频帧和空间区域,从而加强了视频与文本的对齐,因此在该数据集上的增益明显。

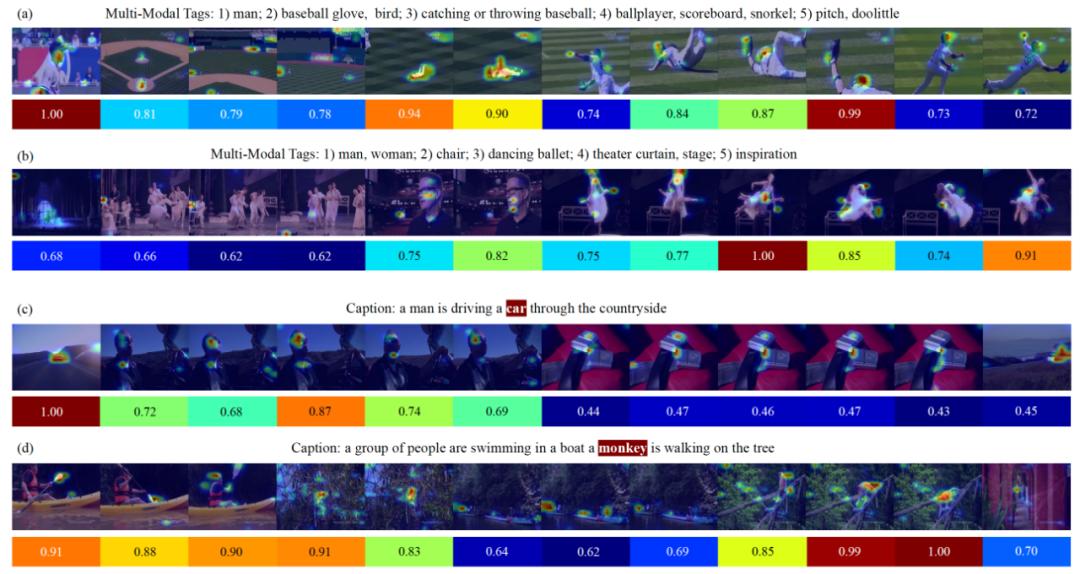

4、可视化结果分析

图三:TABLE 模型的可视化结果。帧序列下方的颜色条表示每一帧的重要程度,而重要程度指的是与多模态标签整体(a、b)或标题中的特定单词(c、d)之间的相关性,由跨模态编码器或联合编码器中的 cross attention 计算得到。每一帧中重要的空间区域进行了不同程度的高亮,由视觉编码器中的 attention 计算得到。

图三中对时间注意力和空间注意力同时进行了可视化。在 (a) 和 (b) 中,多模态特征被视为一个整体,去计算与视觉特征之间的 cross attention。如图所示,cross attention 更加关注与多模态标签高度相关的视频帧,比如 (a) 中,第 1 帧(与 "man" 和 "ballplayer" 相关)与第 10 帧(与 "catching or throwing baseball" 和 "baseball glove" 相关)的权重是最大的。而在每一帧中,模型也聚焦到了一些重要的空间区域,如头、躯干、棒球手套等。虽然多模态标签中可能包含一些噪声,如 (a) 中的 "bird",但由于多模标签是作为一个整体进行视觉注意力的引导,所以模型对于这些微弱的噪声是比较鲁棒的。此外,我们也发现,对于视频检索这项任务,动作标签在 cross attention 中更加占据主导性。例如,在 (b) 中,模型更加关注与 "dancing ballet" 高度相关的第 9 和 12 帧,而与场景、人物相关的帧则没有获得很高的权重。

此外,我们将联合编码器中的 cross attention 也进行了可视化。不同的是,这里计算的是视觉特征与标题中特定单词向量之间的 cross attention。例如,在 (d) 中,第 10 帧和第 11 帧描述的是 "monkey" 的近景,因此在时间注意力上得到了凸显,其他描述 "people" 或 "swimming" 的帧则相对而言被抑制。从这也可以看出,联合编码器可以对视频与单个文本词之间的细粒度相关性进行精准建模,这得益于 VTM 和 MLM 两个辅助任务。

由于联合编码器与跨模态编码器是共享参数的,因此可视化结果也进一步证明了跨模态编码器的能力:它能够在多模态标签的引导下,从冗余的视觉特征中筛选出关键帧和关键区域,有利于视频 - 文本的精准检索。

TABLE 在 QQ 浏览器里的应用

为了满足用户在观看视频时的搜索需求,QQ 浏览器在视频底部会以 “相关搜索” 的方式展现推词,点击推词即可了解更多相关信息。

图四:QQ 浏览器中的应用场景示例

推词既要与视频内容相关,又要能激发用户的点击需求。在相关性的排序上,需要考虑视频多个模态的信息,如标题、视频画面、文字、音频等。而 TABLE 模型可以结合多模态信息,输出一个综合打分,代表视频内容与单条推词的整体相关性。满足相关性条件的推词再经过一些其他的策略(如 ctr 预估、敏感词打压),就可以作为最终的展现结果。

作者团队介绍

QQ 浏览器搜索技术中心团队是腾讯 PCG 信息平台与服务线负责搜索技术研发的团队,依托腾讯内容生态,通过用户研究驱动产品创新,为用户提供图文、资讯、小说、长短视频、服务等多方位的信息需求满足。在算法方面,以自然语言处理、深度学习、多模态理解与生成、知识计算与应用等技术为基础,建设内容理解、相关性和排序、多模态搜索、智能问答、多语言翻译、搜索推荐等技术方向,探索和应用业界先进技术、打造更优秀的用户搜索体验;在工程方面,建设搜索技术中台工业化系统,打磨高性能、高可用、低成本的百亿级检索系统,为腾讯 PCG 各个内容业务的搜索场景提供基础的搜索引擎服务,当前已支持 QQ 浏览器、腾讯视频、腾讯新闻、腾讯微视等 PCG 多条产品线。

腾讯 PCG ARC Lab 是腾讯 PCG 的 “侦察兵”、“特种兵”,站在腾讯探索挑战智能媒体相关前沿技术的第一线。所属的腾讯 PCG 是一个集社交、流量和内容平台于一体的大型事业群,业务需求覆盖了人工智能和大数据方面几乎所有的技术。近两年来 ARC Lab 秉持着做顶天(世界领先)立地(应用落地)的科研的宗旨,已吸引了一批优秀人才和国内外优秀实习生,已在国际顶会上发表 50 余篇论文,多项技术成果落地在实际应用中。© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com

原标题:《AAAI 2023|基于多模态标签聚合的视频检索模型TABLE,多项SOTA》

本文为澎湃号作者或机构在澎湃新闻上传并发布,仅代表该作者或机构观点,不代表澎湃新闻的观点或立场,澎湃新闻仅提供信息发布平台。申请澎湃号请用电脑访问http://renzheng.thepaper.cn。

- 报料热线: 021-962866

- 报料邮箱: news@thepaper.cn

互联网新闻信息服务许可证:31120170006

增值电信业务经营许可证:沪B2-2017116

© 2014-2024 上海东方报业有限公司