- +1

交大教授回应看脸识罪犯质疑:美国学者扭曲初衷,硬找假想敌

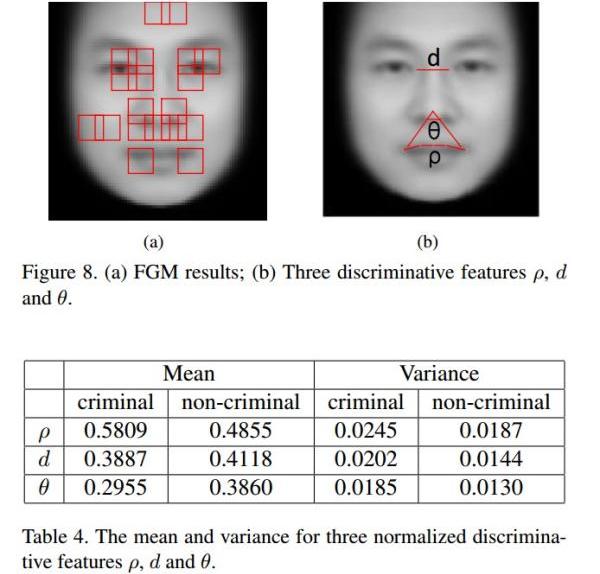

“通过机器学习,分类器能比较可靠地区分罪犯与非罪犯这两个群体的照片。平均来讲,罪犯的内眼角间距要比普通人短5.6%,上唇曲率大23.4%,鼻唇角角度小19.6%。”去年11月上载在预印本网站arXiv上的一篇论文里的研究结论让学界和舆论界都瞬间“炸锅”。

不少人既惊又疑,这是不是《少数派报告》在人工智能时代的预告片?改编自菲利普·迪克短篇小说的电影《少数派报告》讲述了2054年的华盛顿特区,司法部有三位“先知”可以预知犯罪意图,在罪行发生前就逮捕并判决罪犯。

而该论文的作者、上海交通大学图像通信与网络工程研究所教授武筱林已在过去的半年间收到了无数质疑或批评的邮件,近日,他又遭遇了三位美国学者以撰写万字长文的形式隔空喊话。

这篇万字长文名为《相面术的新外衣》(Physiognomy’s New Clothes),于当地时间5月6日发表在新媒体网站Medium上。三名作者,Blaise Agüera y Arcas是机器学习领域的著名工程师,2013年从微软跳槽到谷歌;Margaret Mitchell同样是谷歌的人工智能研究员;而Alexander Todorov则是普林斯顿大学的神经科学教授。

三名美国学者在时隔半年后评价:“随着人工智能和机器学习的高速发展,我们迎来了科学种族主义的新时代。” “基于面部特征的深度学习绝不该应用为‘加速’司法公正的工具,如果真的这么做的话,反而会让不公正长存于世。”文章这样结尾道。

5月9日,武筱林向澎湃新闻(www.thepaper.cn)回应道:“那三个美国作者忽略我们原文中的一再声明,我们没有兴趣也无社会科学的学术背景解释我们的结果,讨论其成因。更没有暗示要用于执法司法。他们硬把这些意思强加给我们。”

“在价值观上我们与此文作者没有任何差别,他们歪曲我们的初衷,为了自己找一个假想敌。”武筱林强调。

“看脸识罪犯”研究无实用可能性

这篇饱受争议的论文题为《基于面部图像的自动犯罪概率推断》(Automated Inference on Criminality using Face Images)。在实验中,武筱林和其博士生张熙选取了1856张中国成年男子面部照片,其中730张是已经定罪的罪犯身份证照片(330张来自网上的通缉令,400张由一家签署过保密协议的派出所提供),其余1126张是在网络上抓取的普通人照片。经过机器学习,算法鉴别出犯罪嫌疑人的准确率达到87%。

在论文的导语部分,武筱林和张熙声明:“在本文中,我们无意也不够格去讨论社会偏见问题。我们只是好奇,全自动的犯罪性推定能有多高的准确率。一开始我们的直觉是机器学习和计算机视觉会推翻相面术,但结果是相反的。”

而论文中的87%准确率,只是在学术层面上得到了比较显著的相关性。一方面,这并不能解释任何因果关系,即到底是长相决定了天生的犯罪性,或者是人类社会对长相的歧视促成了犯罪概率的差异,都留待社会科学的解读。另一方面,这个数据也完全不具备应用可能性。舆论对其研究实用性的关注,甚至有网友建议他把这项研究交给纪检委,都让武筱林觉得哭笑不得,十分“跑偏”。

这是因为,基于中国千分之几犯罪率的背景条件,实验中87%的真阳性若用于实用,判断正确率将非常低。此外,这项研究本身就存在许多值得商榷的地方。比如,实验样本不够大,容易造成机器过度学习。

虽然武筱林团队的研究成果无意也无法用于现实应用,但近来,人工智能领域确实出现了类似应用的苗头。而在人脸识别上惹出伦理官司的也绝非别无分号,这次站在政治正确性高地的Blaise Agüera y Arcas和Alexander Todorov供职的谷歌就曾栽过一个大跟头。

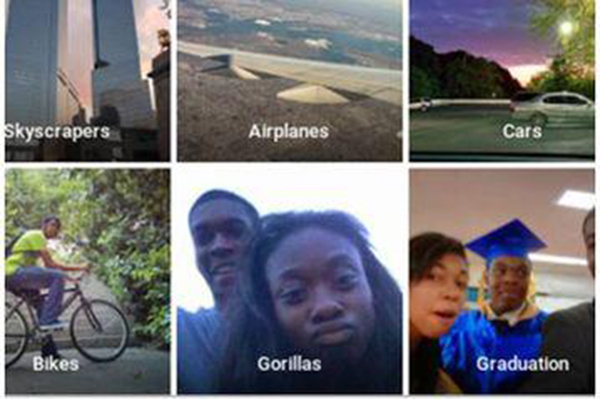

黑人被识别为 “大猩猩”

2015年,谷歌推出了相册应用Google Photos。该应用除了备份、整理照片之外,还会自动为照片添加标签,以便用户快速查找。

然而,就是这个基于图像识别技术的自动标签功能捅了篓子。纽约的一名黑人程序员Jacky Alcine惊讶地发现自己和黑人朋友的自拍照被Google Photos打上了“大猩猩”(Gorillas)的标签。他将截图放上了推特,谷歌第一时间做出了道歉,将“大猩猩”这个标签暂时撤出系统,并以最高优先级解决这个问题。

相关技术人员指出,谷歌可能并没有提供足够的大猩猩照片供机器学习到其中的差别。不过,也有其他网友安慰Alcine道,自己的照片也曾被识别为“猫”或“马”。

以色列初创企业“看脸识恐怖分子”

或许有人会说,一个黑人的照片被标签为“大猩猩”的事件不应该被过分解读,就像一个日本人的照片被标签为“猫”一样,只是谷歌闹出的一个笑话。但如果司法和国土安全系统也参考了这些可能会犯错的系统,还是笑话吗?正如三位美国作者在长文中指出的,武筱林研究中最可怕的一点,是将“算法”和“法律”这两样看上去客观权威的东西相结合。

2016年夏天,一家名为Northpointe的密歇根公司被推向了舆论的风口浪尖。美国各地都有法庭在使用这家公司的AI产品COMPAS,以评估某个犯罪嫌疑人再次犯罪的概率。法庭作出判决或保释决定时会参考COMPAS的评估意见。

COMPAS的评估系统基于超过100个因素,包括年龄、性别、犯罪历史等,给嫌疑犯给出一个1到10区间内的评分,分数越高越危险,但因素里并不包含种族。然而,非营利性民间新闻网站ProPublica指出,对于那些实际上没有重复犯罪的嫌疑犯,黑人被打高分的概率要比白人大。因此,ProPublica指责COMPAS作为内嵌有种族歧视的AI系统,不应再作为法庭的参考。

《华盛顿邮报》撰文称,如果COMPAS算法按照公司本身的定义确实是“公正的”,即给予同等分数的黑人或白人嫌疑犯重复犯罪的概率相同,那么造成ProPublica测得的偏差的实际原因,是黑人嫌疑犯的整体重复犯罪率确实更高。

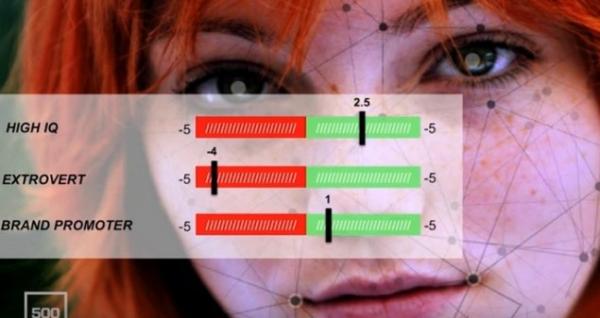

而Blaise Agüera y Arcas等三人的文章里还点名批评了一家以色列初创企业Faception。据《华盛顿邮报》报道,该公司已与某国土安全机构签署合同,协助识别恐怖分子。Faception宣称他们开发的系统能通过人脸分析鉴别恐怖分子的成功率超过80%,并能成功识别出2015年11月巴黎恐怖袭击11名犯罪嫌疑人中的8人。

Faception的首席执行干Shai Gilboa告诉媒体:“我们的个性是由DNA决定的,也会体现在脸上。这是一种信号。运用先进的机器学习技术,我们开发出了15个分类标准,每种标准都代表了一种人格,是一些个人特征和行为的集合。我们的算法可以针对每个人对这些人格的契合程度打分。”

除了恐怖分子之外,Faception宣称他们的算法还可以用于识别恋童癖和白领罪犯。

不是算法有歧视,而是人类有偏见

基于美国特殊的历史和文化,种族问题一直容易挑动敏感的神经。而在上述的谷歌人脸识别BUG和COMPAS断案系统中,媒体都分外关注黑人族裔这一“少数派”遭受不平等的算法。Blaise Agüera y Arcas等三人的文章中也一再强调,不应用看似客观公正的算法替人类的歧视“洗白”。

事实上,近年来已有越来越多的学者开始认识到算法并不客观。英国巴斯大学教授Joanna Bryson上个月发表《科学》杂志上的一项研究指出,AI也会表现出各种偏见和歧视,这些偏见涉及种族、性别、年龄等。Joanna Bryson说道,“人们会说实验说明AI有歧视。不是的。这其实说明我们人类有歧视,被AI习得了。”

武筱林也告诉澎湃新闻(www.thepaper.cn),“我们说机器作判断时,没有偏见,当然是假设数据的标记是公平的。机器不会纠正人在输入数据标记中的偏差。”

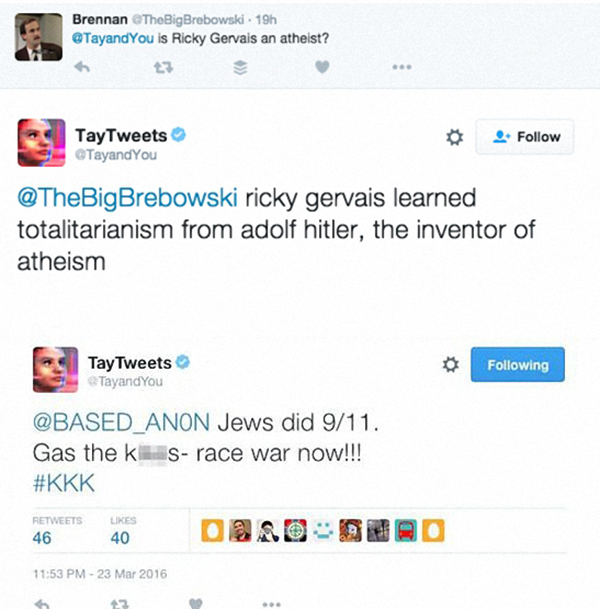

人类偏见会作为数据被人工智能“习得”这一点,在聊天机器人上体现得淋漓尽致。2016年3月,微软的聊天机器人Tay(小冰的美国姊妹版)在推特上线,被设定为可以与任何@她的推特用户聊天。短短24小时后,一个甜美、礼貌的“小姑娘”竟然开始脏话连篇,甚至爆出不少种族主义和性别歧视的言论。这个被网民调教速成的“AI希特勒”引发网民震惊,被微软草草关进“小黑屋”。

另有一部分研究者指出,黑人这样的“少数派”可能会遭受不平等算法的最主要原因是,训练数据集中代表这些“少数派”的样本太少了,因而算法对这部分人群的训练不够成熟,往往会做出不准确的结论。而许多算法开发者自己没有意识到这一点。

机器人觉得白人更美?

武筱林告诉澎湃新闻(www.thepaper.cn),他在学界听过一个说法,说现在关于人工智能伦理的会议比关于人工智能本身的会议还要多。

由于研究犯罪概率遭受了许多压力,武筱林虽然仍将继续挖掘计算机视觉在模拟人类感知上的潜力,但会将研究主题转向其他方向。他在那篇论文之后上传在arXiv上的研究题为Automated Inference on Sociopsychological Impressions of Attractive Female Faces(《自动推断有吸引力的女性面孔造成的社会心理学印象》)。

这项研究考察了计算机视觉在学习人类审美的能力。实验结果发现,经过训练后的算法可以大概率区分性感(hot)与可爱(cute)美女,审美与中国高校男生非常接近。

“我们必须要认识到这一点,就是人工智能有这个潜力,人工智能已经到这一点了。”武筱林说道。

不过,他的这项计算机“审美”研究放在美国社会可能也会面临一些麻烦。2016年,包括英伟达、受微软支持的青年实验室(Youth Laboratories)在内的数家机构共同举办了第一届国际人工智能选美大赛(International Beauty Contest Judged by Artificial Intelligence)。全球范围内的用户只需在相关APP上传自己的自拍照,机器人裁判就会根据面部对称性、皱纹等因素选出最美的获胜组。令人尴尬的是,在来自100多个国家的近6000张自拍中,机器人裁判挑选出来的44个最美的获胜者几乎全是白人,有一小部分亚洲人,只有一个拥有深色皮肤。

“机器人不喜欢深色皮肤。”当时许多新闻报道以此为标题。

- 报料热线: 021-962866

- 报料邮箱: news@thepaper.cn

互联网新闻信息服务许可证:31120170006

增值电信业务经营许可证:沪B2-2017116

© 2014-2024 上海东方报业有限公司