- +1

Facebook、MIT等联合发表451页手稿:用“第一性原理”解释DNN

选自Facebook AI Blog

作者:John Pavlus

机器之心编译

机器之心编辑部

Facebook、普林斯顿大学和 MIT 的 AI 研究人员近日联合出版了一份名为《The Principles of Deep Learning Theory: An Effective Theory Approach to Understanding Neural Networks(深度学习理论原理:理解神经网络的一种有效理论方法)》的研究手稿,用来解释深度学习实际工作原理的理论。

蒸汽机推动了工业革命的发生,并改变了制造业。然而,直到热力学定律和统计力学原理的发展,科学家们才能够在理论层面完全解释蒸汽机的工作原理。

当然,缺乏理论知识并不能阻止人们对蒸汽机的改进,但是有了理论的指导为基础,技术的发展将会更快。当科学家们最终掌握了统计力学时,其影响远远超出了制造更好、更高效的引擎。统计力学使人们认识到物质是由原子构成的,预示着量子力学的发展,如果从整体上看,这甚至促进了为计算机提供动力的晶体管的发展。

今天的人工智能也处于类似的关头。DNN(深度神经网络)是现代 AI 研究的重要组成部分,但它们的实现方式或多或少被视为「黑匣子」。虽然人工智能从业者对 DNN 的理解取得了实质性进展,但 DNN 通常被认为太复杂而无法从基本原理来理解。模型主要通过反复试错进行微调——虽然试错可以智能地进行,通常是根据多年的经验,但它是在没有任何统一的理论语言来描述 DNN 及其功能的情况下进行的。

近日,来自 Facebook 人工智能研究中心(FAIR)的科学家 Sho Yaida,麻省理工学院理论物理中心的研究员、Salesforce 的首席研究员 Dan Roberts 和普林斯顿的 Boris Hanin 合作,撰写了一本关于如何从「第一性原理」来理解 DNN 的书籍《The Principles of Deep Learning Theory: An Effective Theory Approach to Understanding Neural Networks》。该书将于 2022 年初由剑桥大学出版社出版,手稿现在已经公开。

书籍地址:https://arxiv.org/pdf/2106.10165.pdf

「第一性原理」理解 DNN

首先我们来简单了解一下什么是「第一性原理」?

「第一性原理」指的是回归事物最基本的条件,将其拆分成各要素进行解构分析,从而找到实现目标最优路径的方法。

最早提出第一性原理思维的人是亚里士多德,他把它定义为「认知事物的第一基础。」

许多伟大的思想家,包括发明家都使用了第一性原理的思考方法,但是没有人比企业家伊隆 · 马斯克更有效地深入思考第一性原理。这个词的出圈也得益于马斯克的助推。他曾在采访中提到自己特别推崇第一性原理思考法。

书籍作者也是从「第一性原理」来理解 DNN 的。

书籍长达 451 页,开篇引用了量子力学的奠基人、诺贝尔物理学奖得主狄拉克在《量子力学原理》一书序言中的一句话:「这就需要完全脱离历史发展路线,但这种突破是一种优势,因为它使人们能够尽可能直接地接近新的思想。」

在基本层面上,该书提供了一个理论框架,从「第一性原理」理解 DNN。对于人工智能从业者来说,这种理解可以显著减少训练 DNN 所需的试错量。例如,该理论框架可以揭示任何给定模型的最佳超参数,而无需经过当今所需的时间和计算密集型实验。

「该书提出了一种具有吸引力的方法,基于理论物理学中熟悉的扩展来进行机器学习,」斯坦福大学物理学教授 Eva Silverstein 表示道。「这些方法在理解和改进人工智能方面可以带来多大的进步,将是令人兴奋的。」

Facebook VP 兼首席 AI 科学家 Yann LeCun 也在推特上推荐该书,并表示「在科学技术发展史上,工程相关的往往排在第一位:望远镜、蒸汽机、数字通信。解释其功能和局限性的理论往往出现得较晚:折射定律、热力学和信息理论。」「随着深度学习的出现,人工智能驱动的工程奇迹已经进入我们的生活——但我们对深度学习的力量和局限性的理论理解仍然是片面的。这是最早致力于深度学习理论的书籍之一,并以连贯的方式列出了近期理论方法和结果。」

这只是重塑人工智能科学这一更大项目的第一步,这一项目既源自「第一性原理」,又侧重于描述现实模型如何工作。如果成功,这种关于深度学习的一般理论可能会使人工智能模型更加强大,甚至可以指导研究人员建立一个研究智能普遍方面的框架。

相互作用的神经元

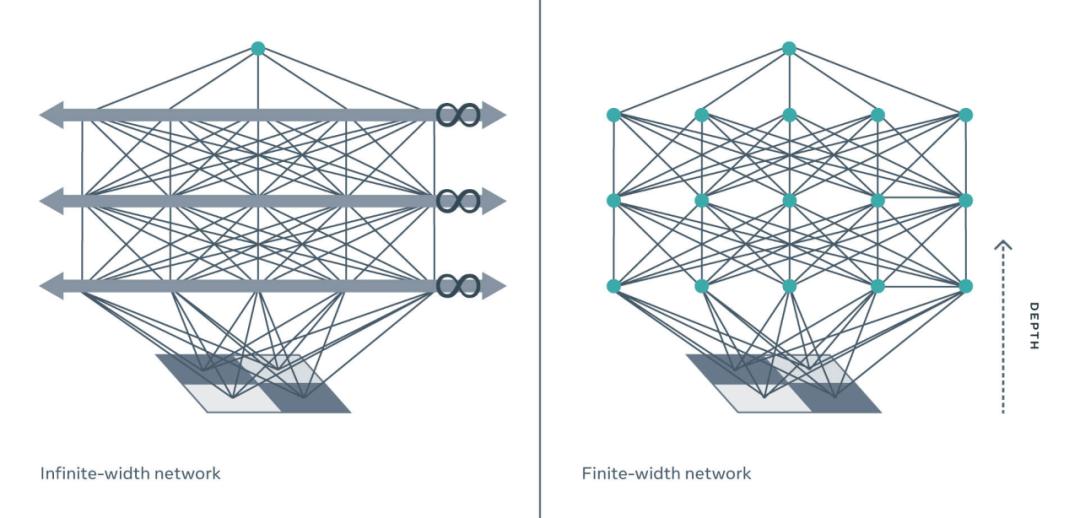

到目前为止,试图理解 DNN 的理论家们通常依赖于网络的理想化,即所谓的「无限宽度限制」,在这种限制下,DNN 的每一层都有无限数量的神经元。

这类似于理想气体定律与真实气体情况。「无限宽度限制」为理论分析提供了一个起点,但它通常与现实世界的深度学习模型几乎没有什么相似之处,尤其是普通的深度神经网络,在那种情况下,抽象将越来越偏离准确的描述。虽然偶尔有用,但「无限宽度限制」过于简单,忽略了真正 DNN 的关键特性,而这些被忽略掉的特性可能就是让 DNN 如此强大的有力工具。

如果从物理学家的角度来处理这个问题,核心是通过在「有限宽度」上建立一个有效的 DNN 理论,从而改进这个无限宽度限制。传统上,物理学家的目标是创造最简单和最理想的模型,同时也包含了描述现实世界所需的最小复杂性。在这里,这需要取消无限宽度限制,并系统地纳入所有必要的修正,以解释有限宽度的影响。在物理学语言中,这意味着对单层和跨层神经元之间的微小相互作用进行建模。

这些听起来像是小的改变,但是现有的玩具模型(toy models)和书中描述的模型在性质上是不同的。想象两个台球朝着对方前进。如果你用一个类似于无限宽度限制的非交互模型来计算即将发生的事情,你会发现这些球互相穿过,继续朝着同一个方向运动。

但事实显然不是这样。球中的电子不能占据同一个空间,所以它们会相互作用碰撞弹跳。

这些交互作用在现实生活中很重要,在物理学中也很重要,对 DNN 来说同样如此。

考虑到神经元之间的类似交互作用,该书的理论发现了 DNN 的真正威力——它们从数据中学习世界表征的能力——与其纵横比(即深度与宽度之比)成正比。对于无限宽度模型,该比率为零,因此这些玩具模型无法捕捉深度,并且随着 DNN 深度的增加,它们的描述变得越来越不准确。相比之下,使用有限宽度层,有效理论(effective theory)实际上会影响深度——这对于表征学习和 DNN 的 D (深度)真正重要的其他应用至关重要。

麻省理工学院物理学副教授、NSF AI 人工智能与基础交互研究所所长 Jesse Thaler 说:「在物理学中,有效场论是理解粒子复杂相互作用的一种严谨而系统的方法。令人兴奋的是,一个类似的、严谨的、系统的方法适用于理解深层网络的动态。在这些发展的启发下,我期待着物理学界和人工智能界进行更有成效的对话。」

虽然本书中描述的框架可以扩展到现代人工智能社区使用的真实世界的 DNN,并为此提供了蓝图,但该书主要侧重于用于教学目的、最简单的深度学习模型(深度多层感知器) 。

应用于这种最简单的结构,可以系统地求解有效理论方程。这意味着我们可以对 DNN 在整个训练轨迹中的行为有一个第一性原理理解。特别地,我们可以明确地写下一个完全训练的 DNN 所计算的函数,来对新的测试例子做出预测。

借助这一新的有效理论,研究者希望理论家们能够推动对神经网络更深入、更全面的理解。虽然还有很多东西需要计算,但这项工作可能使该领域更接近于了解这些模型的哪些特定属性使它们能够智能地执行。

研究者还希望这本书能够帮助 AI 社区减少试错周期,这些试错有时会限制当前研究进展。研究者希望也能帮助 AI 从业者快速设计更好的模型——更高效、性能更好、训练更快,或者所有这些。特别地,设计 DNN 的研究者能够在没有任何训练的情况下选择最优的超参数,并选择最优的算法和模型结构以获得最佳的结果。

多年来,许多人认为这些问题永远无法得到回答或解释。该书籍表明,人工智能不是一门无法解释的艺术,实用的人工智能可以通过基本的科学原理来理解。

研究者希望这只是个开始,并将继续这项研究,将理论框架扩展到其他模型架构并获得新的结果。在更广泛的层面上,研究者希望这本书能够证明,理论能够提供对真实模型的理解。

虽然近年来,实证结果将人工智能推向了新的高度,但研究者坚信,以理论为基础的实践有助于加速人工智能的研究,并有可能发现无法想象的新领域,就像统计力学在一个多世纪前引领信息时代一样。

作者简介

Sho Yaida 为 Facebook 人工智能研究中心(FAIR)的科学家,研究方向是将理论物理学方法应用于理解神经网络。他在斯坦福大学获得博士学位,读博期间主要研究了黑洞,后来在麻省理工学院和杜克大学做博士后时转向了有关玻璃的物理学研究。

个人主页:https://ai.facebook.com/people/sho-yaida/

Dan Roberts 为麻省理工学院理论物理中心的研究员、Salesforce 的首席研究员,同时还是美国国家科学基金会人工智能与基础互动研究所 (IAIFI) 的成员。研究方向集中于如何将理论物理学的工具和观点应用到人工智能中。

个人主页:https://danintheory.com/

此外,还包括研究合作者普林斯顿的 Boris Hanin,主要研究深度学习、概率等。

个人主页:https://hanin.princeton.edu/

原文链接:https://ai.facebook.com/blog/advancing-ai-theory-with-a-first-principles-understanding-of-deep-neural-networks/

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com

原标题:《Facebook、MIT等联合发表451页手稿:用「第一性原理」解释DNN》

本文为澎湃号作者或机构在澎湃新闻上传并发布,仅代表该作者或机构观点,不代表澎湃新闻的观点或立场,澎湃新闻仅提供信息发布平台。申请澎湃号请用电脑访问http://renzheng.thepaper.cn。

- 报料热线: 021-962866

- 报料邮箱: news@thepaper.cn

互联网新闻信息服务许可证:31120170006

增值电信业务经营许可证:沪B2-2017116

© 2014-2024 上海东方报业有限公司