- +1

Nature计算科学综述:经由准实验,从观察数据中推测因果关系

原创 Tony Liu等 集智俱乐部 收录于话题#因果科学19个

导语

在许多数据科学问题中,由观测数据估计因果关系是一项极具挑战但又十分必要的环节。最近一篇发表于 Nature Computational Science 的论文《用准实验量化数据科学中的因果关系》回顾了计量经济学中常用的方法:基于观察数据、利用数据的随机波动——即借助准实验判定因果关系的方法。同时,作者展示了如何将该方法与机器学习相结合,在典型的数据科学环境中回答因果问题。该文还强调了数据科学家如何能够帮助推进这些方法,从而对来自医学、工业和社会中的高维数据进行因果估计。

集智俱乐部联合智源社区,组织,从基础和实操角度出发,精读两本因果科学方向的入门教材。详情见文末。

Tony Liu, Lyle Ungar & Konrad Kording | 作者

郭瑞东 | 译者

赵雨亭、黄俊铭 | 审校

邓一雪 | 编辑

论文题目:

Quantifying causality in data science with quasi-experiments

论文地址:

https://www.nature.com/articles/s43588-020-00005-8

目录

1、准实验方法判定因果的目标

2、观测研究中的混杂因子和碰撞因子

3、准实验策略之工具变量估计

4、准实验策略之断点回归

5、准实验策略之双重差分

6、 准实验的局限性

7、数据科学可以受益于准实验,准实验可以从机器学习中获益

1. 准实验方法判定因果的目标

尽管大多数数据科学都集中于使用统计学和机器学习的工具来进行预测[1],并从数据中“提取洞见”,但许多问题根源都是因果关系,模型所做的预测和所获得的洞见,被用来为决策提供信息。例如,数据科学家可以建立一个机器学习模型来预测哪些患者可能在30天内再次入院,但利益相关者最终想知道可以采取哪些干预或政策,以便降低患者再次入院的风险。数据科学家需要在他们的工具包中添加因果方法,以回答他们打算解决的许多问题中的因果问题。

由于相关性不足以构成因果关系,因此将数据科学分析中,将常见的相关结果误解为因果关系是危险的。任何典型的有监督的机器学习方法(例如,基于一组特征的预测)都不足以推断因果关系,因为用于预测的机器学习模型训练本质上是一个相关性的任务:机器学习模型在做出预测时只是“观察”数据中的特征和结果之间的关系,而非“改变”特征来确定它们对结果的影响[2, 3]。

一个例子:某个用来预测肺炎患者死亡率的模型得出了一个矛盾的结论,即哮喘降低了肺炎患者的死亡率[4]。这个模型没有任何错误:在训练数据中,有哮喘的病人更有可能住进医院、接受更积极的治疗,最终导致较低的死亡率。然而,从决策的角度来看,该模型可能有害,因为在这种预测下,可能会使哮喘病人得不到他们实际需要的额外护理。传统的机器学习总是存在一种风险:那就是未观察到的特征可能正是决定性因素。

已有很多方法,以更适当地从观测数据(没有随机对照实验的情况下)来估计因果关系。该文回顾了标准的准实验方法,这些方法已经在经济学中得到了广泛的应用;但并未在经济学以外广为人知。该文讨论了它们的假设,为什么这些方法应该被更广泛地采用,并用现实世界的例子以及公共数据科学领域的潜在应用来说明作者的观点。最后,该文提倡准实验方法和数据科学的交叉结合:准实验可以在典型的数据科学环境中进行因果推断,而机器学习的创新反过来可以改进这些方法,以便在复杂的数据领域中得到更广泛的应用。

2. 观测研究中的混杂因子和碰撞因子

观测数据对因果推断来说的核心问题存在不被观测到的混淆因素。人们希望确定治疗 x(住院)对结果 y (肺炎风险)的影响,但是有一个隐藏的混淆因子 z(哮喘)同时影响 x 和 y。如果研究人员可以进行一个实验:自行确定X的取值(即令X为自由变量),然后借此消除混淆因素、从而识别 x 对 y 的因果效应(图1a)。实验应用于医学(临床试验)、公共卫生(俄勒冈州医疗补助彩票试验[5])、软件开发和广告(a/b 测试)、以及 ML(强化学习[6, 7, 8])。然而,实验可能代价高昂、违反道德或者不切实际。此外,大多数数据是基于数据科学观察得出的,但科研人员仍然想要估计因果效应。要从观测数据中推断因果关系,通常需要对数据生成过程做不可检验的假设。

图1. 估计实验和观测数据中因果关系的图示法。图A,一个实验研究的图形表示,因为 x 是随机的,导致治疗 x 和混淆因子z 无关。图B,观察性研究的图形表示,在这里碰撞因子 c 和混杂因子 z 都可以导致对因果效应的估计出现偏差。

许多从观察数据中估计因果关系的技术都依赖于假设所有的混杂因素(影响治疗 x 和结果 y 的变量)都在数据中得到观察与解释[9]。在这种情况下,可以控制混杂因素以获得有效的因果估计——例如,通过将它们加入回归。然而,研究人员通常不能知道自己是否记录了所有的混杂因素[10],因此需要对这个假设放置在重要权重上(图1b)。从业者必须解释,他们的数据实际上包含所有相关的混杂因素(而且没有一个碰撞因子),对依赖于混杂因素的分析的批评往往集中在分析中包含缺失变量上。因为没有办法检验缺失变量是否是混杂因素,因果估计的信念取决于混杂因素假设是否可信。

例如,假设在本次肺炎风险问题中,研究人员分析衡量病人的哮喘并控制病情。这项研究可能会被挑刺:还有许多其他潜在的混杂因素没有被考虑在内,比如种族、社会经济地位、吸烟状况、其他病史等等。即使更多的这些潜在的混淆因素被作为研究的一部分进行测量并加以控制,依然可能有别的因素没有考虑到,这可能会威胁到结果的有效性。任何使用观测数据做因果主张的研究,要么使用不依赖于混杂因子的方法,要么需要提供一个令人信服的论据,证明混杂性至少是近似正确的。

除了混杂因子,数据科学家还必须能够识别那些不应该被控制的变量,即所谓的碰撞因子。与同时影响 x 和 y 的混杂因素不同,碰撞因子是受 x 和 y 影响的变量(图1b)。对碰撞因子的控制使研究人员的因果估计出错[11, 12]。例如,他们可以想象在肺炎问题中的一种可能性,即哮喘本身是住院(x)和肺炎(y)的对撞因子:肺炎可能使住院病人更有可能出现哮喘症状,也可能是由于住院期间遭遇过敏。除了测量相关变量以控制混杂,寻求因果估计的数据科学家需要确保被控制的变量不是碰撞因子。

Judea Pearl 推广的结构因果模型(SCM)是计算机科学中一个常用的因果推断框架[11]。SCM 将有向无环图(DAGs)结合起来,用一个数学框架来表达因果关系,该数学框架用于计算来自 DAG 的因果量,称为 do-calculus。结构因果模型的美妙之处在于,一个问题的因果结构可以用图形表示,从而使因果效应的假设和可识别性能更容易理解[13]。

需要有领域知识才能构建结构因果模型中的DAG,并证明在假设的图表中没有缺少混杂因素[3]。虽然研究人员可以通过检查数据中是否反映了变量之间的隐含条件独立性[2],来在一定程度上检验图中变量之间的联系的正确性,但是不包含混淆因素通常是不可检验的[14]。除非人们对假设的DAG 的准确性有强烈的坚持,否则总会存在未被观察到的混杂因素导致可能的因果估计偏差。

还有许多其他技术旨在从观测数据中估计因果效应,尽管它们常常依赖于非混淆假设及其变体。匹配和逆概率加权是社会科学中常用的两种方法,可以用来控制因果估计中的混杂偏差[12, 15]。机器学习方法将处理效果treatment effect估计转换为两个预测任务,允许在高维数据中进行因果推断[16]。

在最近的机器学习领域[18, 19, 20]的活跃研究中,还有一个关于因果发现[17]的热点领域,目标是从数据本身推断出因果关系图:研究人员通常使用无混淆因子作为一种假设。潜变量模型也被应用于观察性因果推断,它不要求不包含混淆因子,但确实需要对影响结果的原因的独立性和数量作出具体的假设[21]。因为在现实世界的问题中,无混杂因子通常很难被证明是正确的,所以科学家们选择在这里强调准实验策略。

3. 准实验策略之工具变量估计

准实验是经济学领域的已经成熟的观测因果关系的框架,利用观测数据中自然存在的随机性来估计因果效应。过去几十年间[22, 23],经济学家越来越多地使用准实验技术来估计现实世界的因果效应。这些方法也依赖于对数据因果结构的假设,但是这些假设可能比不包含混乱因子更合理。下面,本文回顾利用自然发生的随机性来估计因果效应。

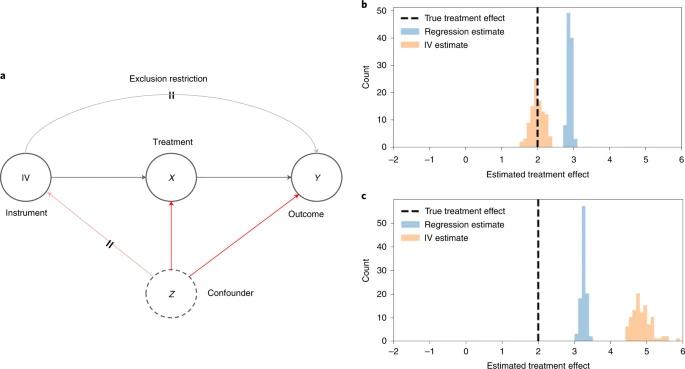

第一个方法称为工具变量估计[24],旨在寻找工具变量,它产生的影响必须通过我们关心的 X 来实现(图2a)。换句话说,研究人员不是要求系统不包括混淆因子,而是要求其某个组成部分不包含混淆因子,然后用它来估计因果关系。

图2. 在有向无环图中的表示工具变量IV 如何影响x 对 y 的因果影响

图A:交叉边描述了有效的工具变量推断所需的假设: 无关假设(交叉灰边)以及工具变量和 y 之间没有未测量的混杂(交叉红边)。当 x 对 y 的真实处理效果(虚线)混淆时。图B:用100个模拟数据集对工具变量(橙色)和典型回归(蓝色)的因果效果直方图进行估计。图C:当 x 对 y 的真实处理效果(虚线)存在混淆因子并违反无关假设时,用100个模拟数据集对 IV (橙色)和典型回归(蓝色)的因果效果直方图进行估计。

经济学中工具变量分析(IV analysis)的一个著名例子考虑了以出生季节(z)为工具变量的必修课程(x)对个人未来工资(y)的影响[25]。在美国的许多州,儿童被要求在他们六岁的时候进入学校,所以在这一年晚些时候出生的人在他们的学校该年级中,相对年轻。由于州法律要求学生在某一特定年龄之前都要上学(例如16岁),因为出生季节的不同,个人被要求上学的时间也不同。只要研究人员能够假设出生季节实际上是随机的,并且其对未来工资的影响必须通过教育水平来实现,那么出生季节就可以作为一种估计因果影响的工具。

为了使用工具变量分析因果关系,必须确定干预(要求的学校教育)、结果(未来工资)和工具变量(出生季节),并假定工具变量只通过对干预的影响来影响结果。然后,研究人员通常执行所谓的两阶段最小二乘法[26],也已经提出了替代工具变量分析框架[27]:在第一阶段(

,其中 α 是拟合系数)对工具变量的处理进行回归,然后根据第一阶段(

,其中 β 是拟合系数)的处理估计结果进行回归。第一阶段由于工具变量的影响,提取了干预中‘不包括混淆因子的部分’,并在研究人员的第二阶段回归中使用这个成分来估计对结果的因果影响,从而控制了过程中的混淆因子:图2b 描述了混淆 x 对 y 的真正治疗效果的模拟数据,可以看到在即使存在混淆因子的因果图中,工具变量分析也给出了不偏不倚的因果估计。另一个令人鼓舞的例子,研究人员可以把前文提到的肺炎患者住院场所与家庭之间距离作为工具变量[28](因为距离医院多远似乎是随机的)。

在进行工具变量分析时,需要作出一些假设,以确保有效的估计。研究人员需要假设没有混淆变量同时影响工具变量本身和结果 y(图2a),这类似于不存在混淆因子的假设,但往往更有道理,因为工具的选择是随机的:论证出生季节与未来的工资是无关的结论,比论证政府干预 x ,即学校教育与未来的工资是无关的更合理。研究人员还需要确保工具变量只通过其对干预的影响影响系统,即所谓的无关假设(图2a):图2c 描述了模拟数据,其中 x 对 y 的真实干预效果是包含混淆因子的,并且无关假设也不符合的。研究人员发现,无论是工具变量分析 还是回归分析,都没有给出正确的因果估计。

工具变量分析要求的另一个关键假设是单调性或无关假设:当受到工具变量的影响时,研究人员的数据样本中没有患者接受了反向治疗[29]。在上面的例子中,如果一些州违背了国家的政策,阻止年龄较晚的个人进入学校,这将产生与其他州相反的效果。此外,成功的工具变量必须与干预密切相关,因为弱相关的工具变量缺乏精确度,无法产生实际上有用的估计。必须确保这些假设得到满足,违反任何这些假设都可能威胁到结论的可信度。

例如,虽然天气是工具变量分析中常用的工具变量[29, 30]——因为天气的变化似乎是随机的——但它可能并不总是合适,这取决于具体的因果问题。对一位行为科学家而言,他希望研究锻炼对心理健康的影响,并计划利用气温作为衡量个人锻炼量的工具变量。虽然这很直观(温度使得个人锻炼的数量可以随机出现),但实际上温度可能与锻炼只有微弱的相关性(例如,人们倾向于在室内锻炼,所以室外温度不是很重要);或者更令人担忧的是,这可能违反了无关假设(温度也可能经由锻炼之外影响心理健康,例如通过季节性情绪失调)。在这种情况下,虽然天气似乎是一个很好的工具变量,仔细考虑便会发现该设计是有缺陷的。

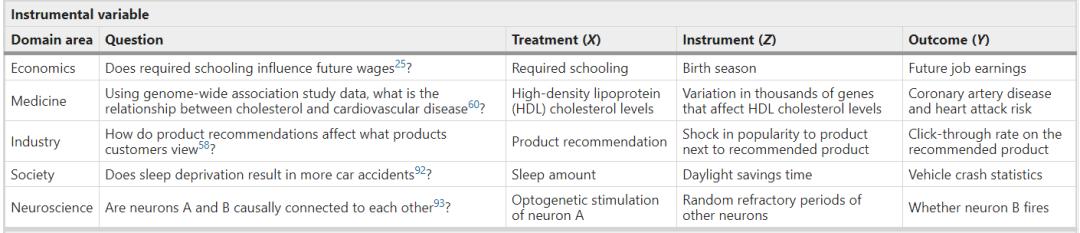

只要我们找到一个合适的工具,使这些假设看似合理,工具变量分析可以广泛用于许多学科,以利用可观测的随机性来源估计非实验数据的因果效应(表1)。

表1. 准实验的现有研究和机会

4. 准实验策略之断点回归

利用自然发生的随机性来估计因果关系的另一种方法是断点回归(Regression discontinuity designs)[32]。在断点回归中,干预变量X是某一连续变量R的跳跃点,其中R可能是年龄、考试或血压读数。因为跳跃点并非渐变(例如,如果年龄在50岁或以上,患者得到癌症筛查,抑或是没有得到),x 值是准随机的,可允许对干预 x 对结果 y 的因果影响进行估计(图3a)。

图3. 断点分析示意图(Regression discontinuity designs)

上图A:描述断点分析如何使用连续变量 R 中的阈值 t 有效地随机化处理 x (交叉红线)来估计其对Y的因果效应。图B:结果Y对连续变量R的散点(蓝点)和局部回归拟合(红线)。拟合分别使用断点(虚线)左右两侧的线性模拟数据。图C:结果Y对连续变量R的散点(蓝点)和局部回归拟合(红线)。拟合分别使用断点(虚线)左右两侧的非线性模拟数据。

断点分析的典型例子是关于高中的学术证书(x)及其对后来的学术成就的影响——如是否获得奖学金(y)。美国高中生参加一个标准化考试,即国家优秀奖学金资格考试(NMSQT) ,满足最低分数线的学生将获得全国认可的优秀证书。这里的连续变量是 NMSQT 测试分数(r)。刚刚达到截止分数的学生与刚刚错过截止分数的学生没有实质上的区别,本质上是随机分配接近截止分数的优异证书。这种半随机化的设计可以估计优异证书与接受阈值附近的学生奖学金之间的因果关系。在前文提到的医疗场景下,使用肺炎风险评分,与阈值判定是否住院的数据,通过断点分析,也可用于进行因果估计。

使用断点分析获得因果估计的一个常用方法是在阈值的左右两侧拟合运行变量 r (测试分数)的结果 y (奖学金数额)的两个模型,称为线性情况下的局部线性回归(图3b 描述模拟数据的局部线性回归)[34, 35]。阈值 x (优异证书)的因果效应大小等于两个拟合回归方程在阈值左右的预测值的差异。实现断点分析的一个实际考虑考虑带宽规模:一个人距离能够并且仍然能够有效地进行随机处理的临界值有多远?较小的带宽使准随机处理更为可信,但也减少了拟合回归的样本容量。然而,更大的带宽可能会在我们的估计中引入偏差,特别是如果断点变量 r 和结果 y 之间的关系是非线性的,如图3C 中的模拟数据所示:注意在阈值左右局部回归之间的差异与结果 y 中的实际不连续变化不匹配。幸运的是,计量经济学一直在探索最佳且由数据驱动的带宽选择方法bandwidth selection methods[36, 37]。在阈值两侧拟合局部模型利用了阈值处理的准随机性,使研究人员能够量化因果效应。

与工具变量分析类似,在执行断点分析时需要一些假设,以确保有效的估计。研究人员假设只有断点变量 r 有一个不连续的跳跃,驱动干预和结果之间的因果关系(图3a)。这个假设可以通过验证其他测量的协变量在 r 的截止值上的连续性而在实践中被证伪。另一个关键的假设要求个体不能完全操纵断点变量,因为这可能使阈值上下的群体无法比较。在研究人员上面的例子中,如果一些学生能够精确地控制他们的考试成绩,以至于他们仅仅通过足够的学习就达到了优秀证书的阈值,这将违反处理的准随机化。经济学家已经为这种操纵变量的运行是否存在开发了检验方法,从而为验证该假设提供了可能[38]。值得注意的是,断点回归分析并不需要不包含混淆因素,才能做出有效的因果估计。由于其相对薄弱和经常可证伪的假设,断点分析被称为最可靠的基于观测数据估计因果关系的准实验方法之一[39]。

然而,尽管每当有一个确定干预与否的阈值时,尝试和应用断点回归分析是非常诱人,但是在一些似是而非的情况下,这些假设并不成立。在实践中需要仔细考虑刚好高于或低于阈值的单位是否具有可比性这一假设,因为当研究中的个体知道阈值和分数时,违规行为经常出现。例如,一个人可以研究补助金对年轻科学家未来学术成就的影响,利用国立卫生研究院的薪水线作为阈值研究补助金对学术成就的因果关系,进行断点回归分析[40, 41]。然而,随着薪水阈值的公布,很可能那些知道自己刚刚错过阈值的科学家们比那些刚刚到达阈值的科学家们更有动力去努力工作,这可能会造成对未来成功的估计的偏差,因为刚刚到达阈值上下的科学家们在动机上存在差异。

只要这些假设是合理的,断点回归分析就有可能广泛地适用于因果效应估计,因为在许多现实数据设置中都存在阈值(表1),即使是在地理界限等非常规设置中也是如此[42]。

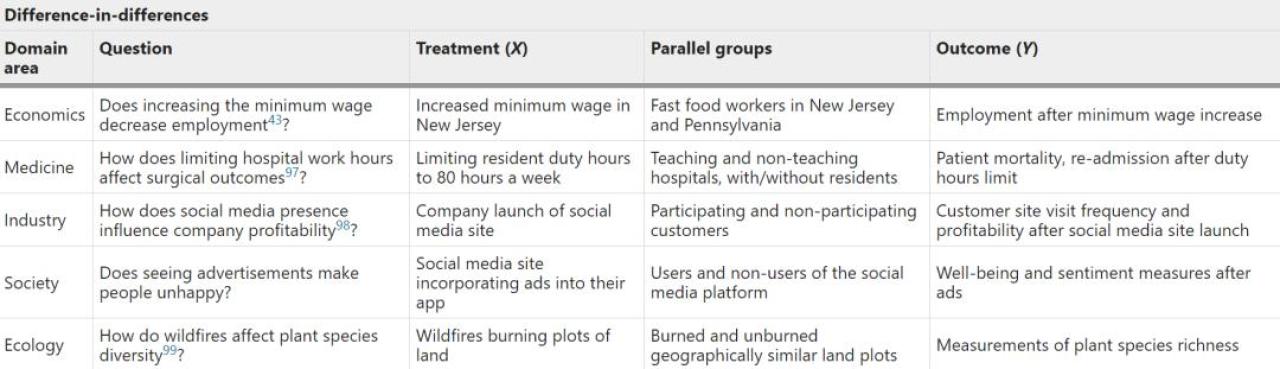

5. 准实验策略之双重差分

第三种标准的计量经济学方法称为双重差分(Difference-in-differences),通过观察治疗组和对照组,并比较他们随着时间推移的结果趋势,来解决观察数据中的混杂因子。研究人员对接受干预的治疗组和不接受治疗的对照组在治疗前(Y1)和治疗后(Y2) x 的时间段内的结果,对 y 进行了测量。治疗组的单纯差异 Y2,治疗 -Y1,治疗可作为 x 的因果效应的估计,但它可能被未观察因素或时间效应所混淆。双重差分的思想是使用差异 Y2,控制 -Y1,控制组作为混杂影响治疗组的估计,通过减去这第二个差异来校正这个影响(图4a)。

图4. 双重差分法示意图

图A:双重差分的图形表示,其中控制组和治疗组都受到混淆因子的 Z1 的影响,但他们在治疗前和治疗后的差异,可以对得到对结果 y 的无偏估计。研究人员必须选择一个适当的控制组,使任何混杂因素都同时影响这两组(图A中只影响治疗组的 Z2的虚线的存在将违反这一规定)。图B:在模拟数据中,随着时间的推移,治疗组(橙色)和对照组(蓝色)的结果 y 的散点图(平行趋势保持),干预 x 被应用于治疗组(虚线)。图C:在违反平行趋势假设的模拟数据中,治疗组(橙色)和对照组(蓝色)随时间的结果 y 散点图。

经济学中,使用双重差分的经典例子是关于提高最低工资(x)对就业(y)的影响[9, 43]。新泽西州在1992年提高了最低工资标准,而与之接壤的宾夕法尼亚州却没有。这项研究比较了政策改变前后,两个州的快餐店就业人数。如果只考虑新泽西州,就业率的变化可能会受到其它因素的影响,比如全国性衰退。然而,通过减去在宾夕法尼亚州观察到的就业差异,作者可以控制潜在的混杂因素。

为了进行双重差分分析,研究人员使用纵向数据来估计对照组和治疗组的 Y1和 Y2(例如,最低工资前后的增长)。估计值可以是在前后时间段内计算的单一期望值,或者,如果从业者希望包括多个时间点和对其他协变量的控制,可以使用时间序列回归进行估计[44, 45]。然后研究人员得到治疗组和对照组之间结果值的估计差异。

,通过减去同样影响对照组和治疗组的混杂因素,得出干预 x 对结果 y 的影响的有效估计:图4B 直观地描述了这一点,治疗组和对照组的预处理趋势线是平行的。研究人员在这里注意到,双重差分是一种特殊的回归方法,用以从时间序列中估计因果关系。双重差分可用于非参数和非线性设定[46, 47, 48]。和双重差分相关,综合控制法(synthetic control)是经济学中发展起来的另一种从时间序列数据中估计因果效应的方法[41]。

像其他的准实验方法一样,双重差分需要满足假设,来确保有效的因果估计。最重要的假设是平行趋势的存在:研究人员要求被实验组和对照组不会随着时间的推移受到混杂因素的不同影响。在上述最低工资的例子中,如果宾夕法尼亚州的劳动力市场与新泽西州的劳动力市场对持续衰退的反应不同,那么这个平行的趋势假设就会被打破。如果纵向数据包含多个时间点,平行趋势假设可以通过在干预 x 发生前检查两组的结果 y 是否存在差异来证伪,图4C 直观地描述了这一过程。

研究需要的另一个假设是不存在溢出效应,即干预本身导致控制和受治疗群体的组成不会发生变化[49]。如果新泽西州新的最低工资标准导致不同的人重新进入就业市场,或者宾夕法尼亚州的人搬到新泽西州,这就违反了上述规定。另一个双重差分假设被违反的例子是这项研究:该研究中,研究人员考察了美国向各国提供的粮食援助对随后发生的国内冲突的影响——美国小麦生产的随机变化影响了向各国提供的援助数量[50]。问题在于,小麦生产与冲突之间的联系随着时间的推移而在“受到干预”和“不受干预”国家之间发生变化,这违反了平行趋势的假设,并表明粮食援助对冲突的影响可能是由虚假的相关关系驱动的[51]。为了使双重差分法有效,我们需要证据来支持平行趋势假设,及不存在溢出效应。

然而,双重差分的透明性和灵活性使其成为一种有吸引力的因果推断技术,前提是进行了适当的控制,并且双重差分发的假设是合理的。由于许多数据科学问题涉及到时间序列,该方法有可能被广泛用于从观测数据中获得因果估计。

6. 准实验的局限性

使用准实验技术所作的因果估计的概括性有其局限性。研究人员回顾的所有方法都是对特定人群的因果效应进行估计。个人自愿评估估计受工具变量的影响的个人的因果效应[52]。断点回归 估计了个人在阈值时的因果效应[53]。在更强有力的假设下,从阈值以外推断因果效应是可行的[54]。双重差分法对选定的治疗组的因果效应进行了估计。然而,研究人员注意到,对可泛化性的关注甚至延伸到了随机化实验,即参与者的人口统计学可以将因果发现限制在一个特定的人群中[55]。当应用准实验方法时,就像所有的因果分析一样,研究人员必须留意这些估计对哪些人群是有效的。

一个实际的考虑是,准实验需要一个特定的数据生成过程或观察到应用的特定类型的变量,例如与干预密切相关的工具变量、断点回归中阈值的存在与否;或是否存在一个适当的控制组随着时间的推移,可与治疗组进行比较。因此,使用准实验方法估计因果效应取决于数据是否符合这些框架,因为人们通常不能将现有数据改造成这些方法中的一种:“实验设计胜过分析”[56]。

此外,在没有适当考虑技术的基础假设的情况下,寻找适合这些设计的数据存在一些风险,如果不满足这些假设,分析可能会失效。正如上一节所讨论的那样,如果仔细考虑假设,从表面上看,似乎适合应用这些方法的数据也可能不会奏效。

7. 数据科学可以受益于准实验,

准实验可以从机器学习中获益

准实验应该更广泛地应用于数据科学 ,因为它们是在许多情况下有意义地估计因果关系的唯一方式。例如,工具变量分析被用来评估推荐系统的因果效应[57],即利用产品受欢迎程度中的随机冲击作为工具变量[58]。在流行病学中,一种流行的技术叫做孟德尔随机化,它使用遗传变异作为工具变量[59, 60]。断点分析在医疗实践中比比皆是,同时也应该扩展至更多应用[61]。双重差分法可以用来评估政策和执行在诸如广告[62]和公共健康[63]等各个领域的长期效果。准实验策略可以估计在这些情况下的因果效应,为决策提供有用的反馈。

此外,研究人员可以将这些准实验中的因果估计与其他数据结合起来,以提高机器学习的性能。例如,在基于观察研究中,已经有使用重叠实验数据来控制混杂因子的工作,这可以扩展到利用准实验数据[64]。在与环境互动的过程中,强化学习执行干预、做出决策和形成政策,这些都是固有的因果任务[11, 65]。

然而,现代的强化学习往往需要很昂贵的训练成本,因此纳入准实验的因果效应估计可能是一个有希望的提高效率的方式[66]。特别是,为了优化策略,已将断点分析应用于多臂老虎机问题[67]。随着对因果关系的重新关注[69, 70],人们对可解释的人工智能[68]产生了极大的兴趣:当人们改变输入特征时,机器学习模型的预测是如何改变的?

虽然一些可解释的人工智能方法依赖于对数据进行扰动以产生解释[71, 72],但是利用数据中自然发生的随机性来估计因果效应以保留原始数据的特征分布是有价值的,因为当给出一个分布不均匀的输入数据时,机器学习模型可以表现得不符合常规[73]。结合准实验和对他们的无偏因果估计,加上更灵活和更强大的机器学习方法,保证了这些方法能取长补短。

传统的经济学工作更多地关注参数估计(例如,估计和解释回归系数)而非预测,这为机器学习融入准实验方法带来了机会[74]。在某些情况下,研究人员可以用更灵活的机器学习方法来代替传统方法中使用的参数估计。例如工具变量分析中的第一阶段回归实际上是一个预测任务。利用 LASSO 回归、核方法和深度学习算法[75, 76, 77],将工具变量扩展到高维数据、非线性数据域。从时间序列数据推断因果关系也越来越受到关注,在时间序列数据中,集合模型和矩阵填充(matirix completion)方法被用于因果估计[78, 79]。使用机器学习技术,结合时间序列中因果推断,这一应用方向前途光明。

另一个机器学习可以改进准实验的领域是精准定位目标人群来进行因果估计。通过准实验所作的估计只对特定群体有效——例如工具变量分析和断点回归中受某种工具或阈值影响的个人。预测哪些个体可能对某种干预或工具变量产生反应[80, 81, 82],可以增加因果估计的可解释性,并为研究设计提供排除标准。此外,机器学习方法擅长优化损失函数,这可以用于精准干预策略的制定。例如,为了最大限度地发挥干预效果或最大限度地减少潜在危害[83, 84],研究人员已经开展了优化断点分析处理阈值的工作。机器学习扩展后的准实验方法可描述因果适用的目标人群,为更好的政策选择提供了信息。

实验经济学家对使用机器学习和数据科学很感兴趣[74, 85, 86]。除了本文已经回顾过的场景之外,还有其他场景下的因果推断方法,例如在干扰下(个人的干预分配可能影响他人的结果)[87],或者在网络数据[88]中。随着机器学习方法的普及,数据科学家和机器学习研究人员应该寻找与经济学界合作的机会。

就像因果关系在营销[89]和神经科学[90]等领域被强调为中心问题一样,人们需要更广泛地认识到,许多数据科学问题就是找到自然界中的因果关系[3]。研究人员提倡数据科学家通过一个因果透镜来看待他们正在研究的问题: 这个问题是否能通过相关性或预测来回答,或者是否存在一个潜在的因果机制?如果目标是了解决策、行动或干预,数据科学家需要仔细考虑他们的数据:这是观察性的还是实验性的,是否存在对未观察到的混杂变量,以及可以采取什么方法来控制混杂因子?准实验是一套可以成功地识别混杂因果效应的方法,其应成为数据科学家工具包的一部分,就像它们已成为经济学家工具包的一部分一样[49, 91]。

数据科学和准实验的传统用户相互合作会带来新的机会。因果关系需要在数据科学中发挥更大的作用,准实验为从观测数据中获得的因果关系提供了实用的测量方法。与此同时,机器学习和数据科学的创新正在经济学中得到应用,而这些思想在复杂数据领域的持续应用可以扩大经济学家和其他社会科学家可以提出问题的范围。可以设想,在未来,更多的数据科学明确地围绕着因果关系展开,其他领域如经济学可以利用机器学习的进步来帮助回答他们自己的因果问题。

参考文献

1. van Dyk, D. et al. ASA statement on the role of statistics in data science. Amstat News https://magazine.amstat.org/blog/2015/10/01/ asa-statement-on-the-role-of-statistics-in-data-science/ (2015).

2. Pearl, J. Te seven tools of causal inference, with refections on machine learning. Commun. ACM 62, 54–60 (2019).

3. Hernán, M. A., Hsu, J. & Healy, B. Data science is science’s second chance to get causal inference right: a classifcation of data science tasks. Chance 32, 42–49 (2019).

4. Caruana, R. et al. Intelligible models for healthcare: predicting pneumonia risk and hospital 30-day readmission. In Proc. 21th ACM SIGKDD International Conference on Knowledge Discovery and Data Mining 1721–1730 (ACM Press, 2015); https://doi.org/10.1145/2783258.2788613

5. Finkelstein, A. et al. Te Oregon health insurance experiment: evidence from the frst year. Q. J. Econ. 127, 1057–1106 (2012).

6. Forney, A., Pearl, J. & Bareinboim, E. Counterfactual data-fusion for online reinforcement learners. In International Conference on Machine Learning (eds. Precup, D. & Teh, Y. W.) 1156–1164 (PMLR, 2017).

7. Tomas, P. S. & Brunskill, E. Data-efcient of-policy policy evaluation for reinforcement learning. International Conference on Machine Learning (eds. Balcan, M. F. & Weinberger, K.) 2139–2148 (PMLR, 2016).

8. Athey, S. & Wager, S. Policy learning with observational data. Econometrica (in the press).

9. Angrist, J. D. & Pischke, J.-S. Mostly Harmless Econometrics: An Empiricist’s Companion (Princeton Univ. Press, 2008).

10. Imbens, G. & Rubin, D. B. Causal Inference: For Statistics, Social and Biomedical Sciences: An Introduction (Cambridge Univ. Press 2015).

11. Pearl, J. Causality (Cambridge Univ. Press, 2009).

12. Hernán, M. A. & Robins, J. M. Causal Inference: What If (Chapman & Hall/ CRC, 2020).

13. Pearl, J. Causal inference in statistics: an overview. Stat. Surv. 3, 96–146 (2009).

14. Peters, J., Janzing, D. & Schölkopf, B. Elements of Causal Inference: Foundations and Learning Algorithms (MIT Press, 2017).

15. Rosenbaum, P. R. & Rubin, D. B. Te central role of the propensity score in observational studies for causal efects. Biometrika 70, 41–55 (1983).

16. Chernozhukov, V. et al. Double/debiased machine learning for treatment and structural parameters. Econ. J. 21, C1–C68 (2018).

17. Spirtes, P., Glymour, C. N. & Scheines, R. Causation, Prediction, and Search (MIT Press, 2000).

18. Schölkopf, B. Causality for machine learning. Preprint at https://arxiv.org/ abs/1911.10500 (2019).

19. Mooij, J. M., Peters, J., Janzing, D., Zscheischler, J. & Schölkopf, B. Distinguishing cause from efect using observational data: methods and benchmarks. J. Mach. Learn. Res. 17, 1103–1204 (2016).

20. Huang, B. et al. Causal discovery from heterogeneous/nonstationary data. J. Mach. Learn. Res. 21, 1–53 (2020).

21. Wang, Y. & Blei, D. M. Te blessings of multiple causes. J. Am. Stat. Assoc. 114, 1574–1596 (2019).

22. Leamer, E. E. Let’s take the con out of econometrics. Am. Econ. Rev. 73, 31–43 (1983).

23. Angrist, J. D. & Pischke, J.-S. Te credibility revolution in empirical economics: how better research design is taking the con out of econometrics. J. Econ. Perspect.

24, 3–30 (2010). 24. Angrist, J. D. & Krueger, A. B. Instrumental variables and the search for identifcation: from supply and demand to natural experiments. J. Econ. Perspect. 15, 69–85 (2001).

25. Angrist, J. D. & Krueger, A. B. Does compulsory school attendance afect schooling and earnings? Q. J. Econ. 106, 979–1014 (1991).

26. Wooldridge, J. M. Econometric Analysis of Cross Section and Panel Data (MIT Press, 2010).

27. Angrist, J. D., Imbens, G. W. & Krueger, A. B. Jackknife instrumental variables estimation. J. Appl. Econom. 14, 57–67 (1999).

28. Newhouse, J. P. & McClellan, M. Econometrics in outcomes research: the use of instrumental variables. Annu. Rev. Public Health 19, 17–34 (1998).

29. Imbens, G. Potential Outcome and Directed Acyclic Graph Approaches to Causality: Relevance for Empirical Practice in Economics Working Paper No. 26104 (NBER, 2019); https://doi.org/10.3386/w26104

30. Hanandita, W. & Tampubolon, G. Does poverty reduce mental health? An instrumental variable analysis. Soc. Sci. Med. 113, 59–67 (2014).

31. Angrist, J. D., Graddy, K. & Imbens, G. W. Te interpretation of instrumental variables estimators in simultaneous equations models with an application to the demand for fsh. Rev. Econ. Stud. 67, 499–527 (2000).

32. Tistlethwaite, D. L. & Campbell, D. T. Regression-discontinuity analysis: an alternative to the ex post facto experiment. J. Educ. Psychol. 51, 309–317 (1960).

33. Fine, M. J. et al. A prediction rule to identify low-risk patients with community-acquired pneumonia. N. Engl. J. Med. 336, 243–250 (1997).

34. Lee, D. S. & Lemieux, T. Regression discontinuity designs in economics. J. Econ. Lit. 48, 281–355 (2010).

35. Cattaneo, M. D., Idrobo, N. & Titiunik, R. A Practical Introduction to Regression Discontinuity Designs (Cambridge Univ. Press, 2019).

36. Imbens, G. & Kalyanaraman, K. Optimal Bandwidth Choice for the Regression Discontinuity Estimator Working Paper No. 14726 (NBER, 2009); https://doi. org/10.3386/w14726

37. Calonico, S., Cattaneo, M. D. & Titiunik, R. Robust data-driven inference in the regression-discontinuity design. Stata J. 14, 909–946 (2014).

38. McCrary, J. Manipulation of the running variable in the regression discontinuity design: a density test. J. Econ. 142, 698–714 (2008).

39. Imbens, G. & Lemieux, T. Regression discontinuity designs: a guide to practice. J. Economet. 142, 615–635 (2008).

40. NCI funding policy for RPG awards. NIH: National Cancer Institute https://deainfo.nci.nih.gov/grantspolicies/fnalfundltr.htm (2020).

41. NIAID paylines. NIH: National Institute of Allergy and Infectious Diseases http://www.niaid.nih.gov/grants-contracts/niaid-paylines (2020).

42. Keele, L. J. & Titiunik, R. Geographic boundaries as regression discontinuities. Polit. Anal. 23, 127–155 (2015).

43. Card, D. & Krueger, A. B. Minimum Wages and Employment: A Case Study of the Fast Food Industry in New Jersey and Pennsylvania Working Paper No. 4509 (NBER, 1993); https://doi.org/10.3386/w4509

44. Ashenfelter, O. & Card, D. Using the Longitudinal Structure of Earnings to Estimate the Efect of Training Programs Working Paper No. 1489 (NBER, 1984); https://doi.org/10.3386/w1489

45. Angrist, J. D. & Krueger, A. B. in Handbook of Labor Economics Vol. 3 (eds. Ashenfelter, O. C. & Card, D.) 1277–1366 (Elsevier, 1999).

46. Athey, S. & Imbens, G. W. Identifcation and inference in nonlinear diference-in-diferences models. Econometrica 74, 431–497 (2006).

47. Abadie, A. Semiparametric diference-in-diferences estimators. Rev. Econ. Stud. 72, 1–19 (2005).

48. Lu, C., Nie, X. & Wager, S. Robust nonparametric diference-in-diferences estimation. Preprint at https://arxiv.org/abs/1905.11622 (2019).

49. Besley, T. & Case, A. Unnatural experiments? estimating the incidence of endogenous policies. Econ. J. 110, 672–694 (2000).

50. Nunn, N. & Qian, N. US food aid and civil confict. Am. Econ. Rev. 104, 1630–1666 (2014).

51. Christian, P. & Barrett, C. B. Revisiting the Efect of Food Aid on Confict: A Methodological Caution (Te World Bank, 2017); https://doi. org/10.1596/1813-9450-8171.

52. Angrist, J. & Imbens, G. Identifcation and Estimation of Local Average Treatment Efects Technical Working Paper No. 118 (NBER, 1995); https://doi.org/10.3386/t0118

53. Hahn, J., Todd, P. & Van der Klaauw, W. Identifcation and estimation of treatment efects with a regression-discontinuity design. Econometrica 69, 201–209 (2001).

54. Angrist, J. & Rokkanen, M. Wanna Get Away? RD Identifcation Away from the Cutof Working Paper No. 18662 (NBER, 2012); https://doi.org/10.3386/ w18662

55. Rothwell, P. M. External validity of randomised controlled trials: “To whom do the results of this trial apply?”. Te Lancet 365, 82–93 (2005).

56. Rubin, D. B. For objective causal inference, design trumps analysis. Ann. Appl. Stat. 2, 808–840 (2008).

57. Chaney, A. J. B., Stewart, B. M. & Engelhardt, B. E. How algorithmic confounding in recommendation systems increases homogeneity and decreases utility. In Proc. 12th ACM Conference on Recommender Systems 224–232 (Association for Computing Machinery, 2018); https://doi. org/10.1145/3240323.3240370.

58. Sharma, A., Hofman, J. M. & Watts, D. J. Estimating the causal impact of recommendation systems from observational data. In Proc. Sixteenth ACM Conference on Economics and Computation 453–470 (Association for Computing Machinery, 2015); https://doi.org/10.1145/2764468.2764488

59. Lawlor, D. A., Harbord, R. M., Sterne, J. A. C., Timpson, N. & Smith, G. D. Mendelian randomization: using genes as instruments for making causal inferences in epidemiology. Stat. Med. 27, 1133–1163 (2008).

60. Zhao, Q., Chen, Y., Wang, J. & Small, D. S. Powerful three-sample genome-wide design and robust statistical inference in summary-data Mendelian randomization. Int. J. Epidemiol. 48, 1478–1492 (2019).

61. Moscoe, E., Bor, J. & Bärnighausen, T. Regression discontinuity designs are underutilized in medicine, epidemiology, and public health: a review of current and best practice. J. Clin. Epidemiol. 68, 132–143 (2015).

62. Blake, T., Nosko, C. & Tadelis, S. Consumer heterogeneity and paid search efectiveness: a large-scale feld experiment. Econometrica 83, 155–174 (2015).

63. Dimick, J. B. & Ryan, A. M. Methods for evaluating changes in health care policy: the diference-in-diferences approach. JAMA 312, 2401–2402 (2014).

64. Kallus, N., Puli, A. M. & Shalit, U. Removing hidden confounding by experimental grounding. Adv. Neural Inf. Process. Syst. 31, 10888–10897 (2018).

65. Zhang, J. & Bareinboim, E. Markov Decision Processes with Unobserved Confounders: A Causal Approach. Technical Report (R-23) (Columbia CausalAI Laboratory, 2016).

66. Mnih, V. et al. Human-level control through deep reinforcement learning. Nature 518, 529–533 (2015).

67. Lansdell, B., Triantafllou, S. & Kording, K. Rarely-switching linear bandits: optimization of causal efects for the real world. Preprint at https://arxiv.org/ abs/1905.13121 (2019).

68. Adadi, A. & Berrada, M. Peeking inside the black-box: a survey on explainable artifcial intelligence (XAI). IEEE Access 6, 52138–52160 (2018).

69. Zhao, Q. & Hastie, T. Causal interpretations of black-box models. J. Bus. Econ. Stat. 39, 272–281 (2021).

70. Morafah, R., Karami, M., Guo, R., Raglin, A. & Liu, H. Causal interpretability for machine learning—problems, methods and evaluation. ACM SIGKDD Explor. Newsl. 22, 18–33 (2020).

71. Ribeiro, M. T., Singh, S. & Guestrin, C. ‘Why should I trust you?’: Explaining the predictions of any classifer. In Proc. 22nd ACM SIGKDD International Conference on Knowledge Discovery and Data Mining 1135–1144 (Association for Computing Machinery, 2016); https://doi.org/10.1145/2939672.2939778

72. Mothilal, R. K., Sharma, A. & Tan, C. Explaining machine learning classifers through diverse counterfactual explanations. In Proc. 2020 Conference on Fairness, Accountability, and Transparency 607–617 (Association for Computing Machinery, 2020); https://doi.org/10.1145/3351095.3372850

73. Hooker, G. & Mentch, L. Please stop permuting features: an explanation and alternatives. Preprint at https://arxiv.org/abs/1905.03151 (2019).

74. Mullainathan, S. & Spiess, J. Machine learning: an applied econometric approach. J. Econ. Perspect. 31, 87–106 (2017).

75. Belloni, A., Chen, D., Chernozhukov, V. & Hansen, C. Sparse models and methods for optimal instruments with an application to eminent domain. Econometrica 80, 2369–2429 (2012).

76. Singh, R., Sahani, M. & Gretton, A. Kernel instrumental variable regression. Adv. Neural Inf. Process. Syst. 32, 4593–4605 (2019).

77. Hartford, J., Lewis, G., Leyton-Brown, K. & Taddy, M. Deep IV: a fexible approach for counterfactual prediction. In Proc. 34th International Conference on Machine Learning Vol. 70 (eds. Precup, D. & Teh Y. W.) 1414–1423 (JMLR.org, 2017).

78. Athey, S., Bayati, M., Doudchenko, N., Imbens, G. & Khosravi, K. Matrix Completion Methods for Causal Panel Data Models Working Paper No. 25132 (NBER, 2018); https://doi.org/10.3386/w25132

79. Athey, S., Bayati, M., Imbens, G. & Qu, Z. Ensemble methods for causal efects in panel data settings. AEA Pap. Proc. 109, 65–70 (2019).

80. Kennedy, E. H., Balakrishnan, S. & G’Sell, M. Sharp instruments for classifying compliers and generalizing causal efects. Ann. Stat. 48, 2008–2030 (2020).

81. Kallus, N. Classifying treatment responders under causal efect monotonicity. In Proc. 36th International Conference on Machine Learning Vol. 97 (eds. Chaudhuri, K. & Salakhutdniov, R.) 3201–3210 (PMLR, 2019).

82. Li, A. & Pearl, J. Unit selection based on counterfactual logic. In Proc. Twenty-Eighth International Joint Conference on Artifcial Intelligence (ed. Kraus, S.) 1793–1799 (International Joint Conferences on Artifcial Intelligence Organization, 2019); https://doi.org/10.24963/ijcai.2019/248

83. Dong, Y. & Lewbel, A. Identifying the efect of changing the policy threshold in regression discontinuity models. Rev. Econ. Stat. 97, 1081–1092 (2015).

84. Marinescu, I. E., Triantafllou, S. & Kording, K. Regression discontinuity threshold optimization. SSRN https://doi.org/10.2139/ssrn.3333334 (2019).

85. Varian, H. R. Big data: new tricks for econometrics. J. Econ. Perspect. 28, 3–28 (2014).

86. Athey, S. & Imbens, G. W. Machine learning methods that economists should know about. Annu. Rev. Econ. 11, 685–725 (2019).

87. Hudgens, M. G. & Halloran, M. E. Toward causal inference with interference. J. Am. Stat. Assoc. 103, 832–842 (2008).

88. Graham, B. & de Paula, A. Te Econometric Analysis of Network Data (Elsevier, 2019).

89. Varian, H. R. Causal inference in economics and marketing. Proc. Natl. Acad. Sci. USA 113, 7310–7315 (2016).

90. Marinescu, I. E., Lawlor, P. N. & Kording, K. P. Quasi-experimental causality in neuroscience and behavioural research. Nat. Hum. Behav. 2, 891–898 (2018).

91. Abadie, A. & Cattaneo, M. D. Econometric methods for program evaluation. Annu. Rev. Econ. 10, 465–503 (2018).

(参考文献可上下滑动查看)

因果科学第二季读书会报名中

因果推断与机器学习领域的结合已经吸引了越来越多来自学界业界的关注,为深入探讨、普及推广因果科学议题,帮助其他领域如经济学可以利用机器学习的进步来帮助回答他们自己的因果问题,集智俱乐部携手智源社区将举办第二季「」。本期读书会着力于实操性、基础性,将带领大家精读因果科学方向两本非常受广泛认可的入门教材。

1. Pearl, Judea, Madelyn Glymour, and Nicholas P. Jewell. Causal inference in statistics: A primer. John Wiley & Sons, 2016.(本书中译版《统计因果推理入门(翻译版)》已由高等教育出版社出版)

2. Peters, Jonas, Dominik Janzing, and Bernhard Schölkopf. Elements of causal inference: foundations and learning algorithms. The MIT Press, 2017.

读书会每周将进行直播讨论,进行问题交流、重点概念分享、阅读概览和编程实践内容分析。非常适合有机器学习背景,希望深入学习因果科学基础知识和重要模型方法,寻求解决相关研究问题的朋友参加。

目前因果科学读书会系列,已经有接近400多位的海内外高校科研院所的一线科研工作者以及互联网一线从业人员参与,吸引了国内和国际上大部分的因果科学领域的专业科研人员,如果你也对这个主题感兴趣,想要深度地参与,就快加入我们吧!

详情请点击:

报名:(长期有效)

第一步:扫码填写报名信息。

第二步:信息填写之后,进入付款流程,提交保证金299元。(符合退费条件后可退费。)

第三步:添加负责人微信,拉入对应的读书会讨论群。

我们也会对每次分享的内容进行录制,剪辑后发布在集智学园的官网上,供读书会成员回看。

因果科学读书会第二季第一期将在周日(3月21日)上午10:00开展,我们将和大家一起来建立对因果科学的全局认知,系统了解因果推断,从而打好基础,在接下来的读书会内容学习中起到事半功倍的效果。

本次分享邀请了英国剑桥大学机器学习组博士生陆超超来进行分享,他将从以下几个方面跟大家展开深度的讨论:

1. 讲述因果推断的两大框架:潜在结果模型和结构因果模型,讨论他们各自的优缺点以及他们之间的联系,详细介绍他们之间的转化规律。

2. 与大家一起深入探讨因果推断中最基本的概念、定理以及它们产生的缘由,了解每个概念背后的故事,从而建立起对因果更全面的感知。

3. 分享它们在不同学科中的具体的应用,包括社会科学、经济学、医学、机器学习等,借助这些应用,进一步启发大家用因果科学思维来思考和解决问题。

原标题:《Nature计算科学综述:经由准实验,从观察数据中推测因果关系》

本文为澎湃号作者或机构在澎湃新闻上传并发布,仅代表该作者或机构观点,不代表澎湃新闻的观点或立场,澎湃新闻仅提供信息发布平台。申请澎湃号请用电脑访问http://renzheng.thepaper.cn。

- 报料热线: 021-962866

- 报料邮箱: news@thepaper.cn

互联网新闻信息服务许可证:31120170006

增值电信业务经营许可证:沪B2-2017116

© 2014-2025 上海东方报业有限公司